Hadoop的wordcount程序的简单使用(伪分布式的)

安装hadoop的版本在这里查看:本人使用的hadoop版本以及安装

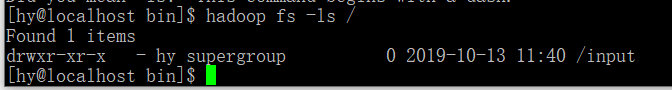

1.向hadoop中创建文件夹input

cd bin/

hadoop fs -mkdir input/

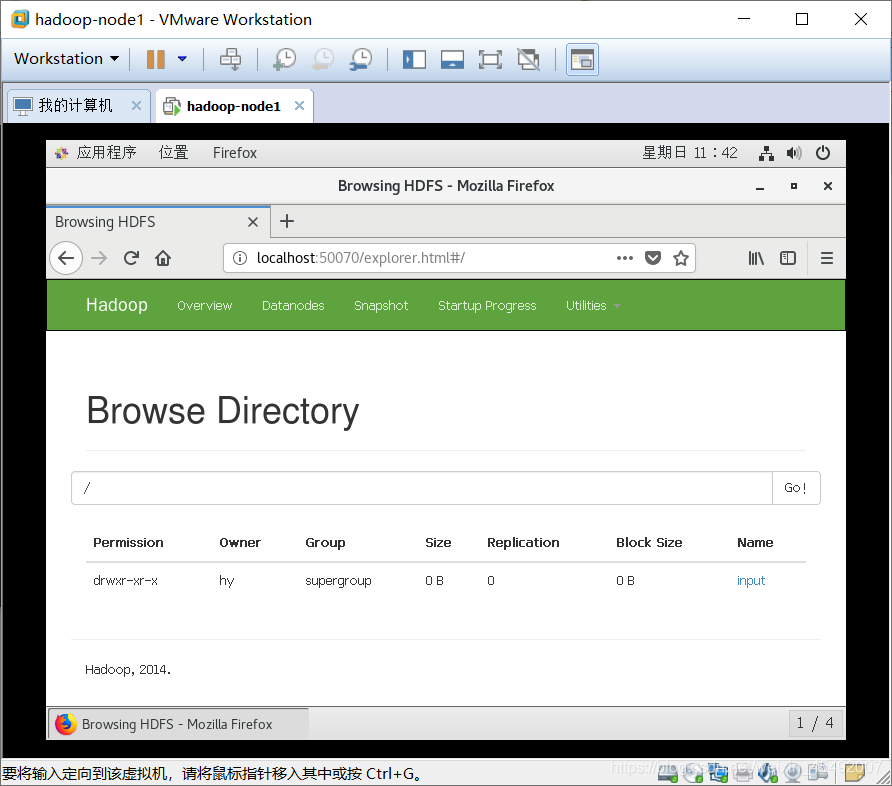

2.查看常见的input文件夹

hadoop fs -ls /

通过web页面查看

3.创建文件并上传到hadoop中

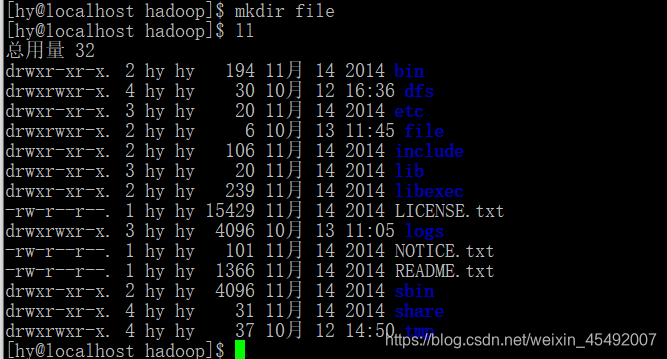

1.创建file文件夹

cd ..

mkdir file

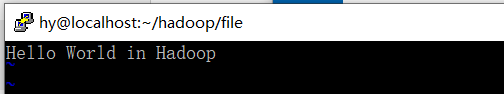

2.在file文件夹中创建file1.txt和file2.txt

cd file/

touch file1.txt

touch file2.txt

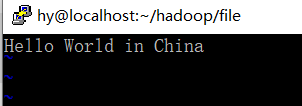

3.向file1和file2文件中添加数据

4.将当前的文件放入hadoop中的input文件夹

cd file/

hadoop fs -input file1.txt /input/

hadoop fs -input file2.txt /input/

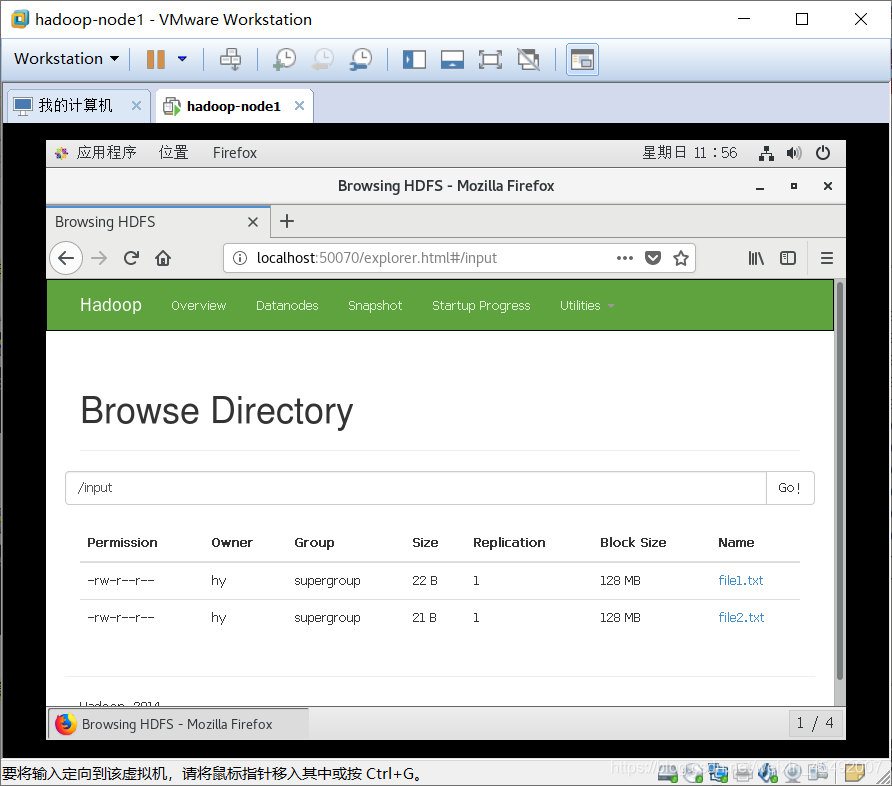

查看是否已经推送成功

hadoop fs -ls /input

通过web查看

4.使用share中的wordcount用例

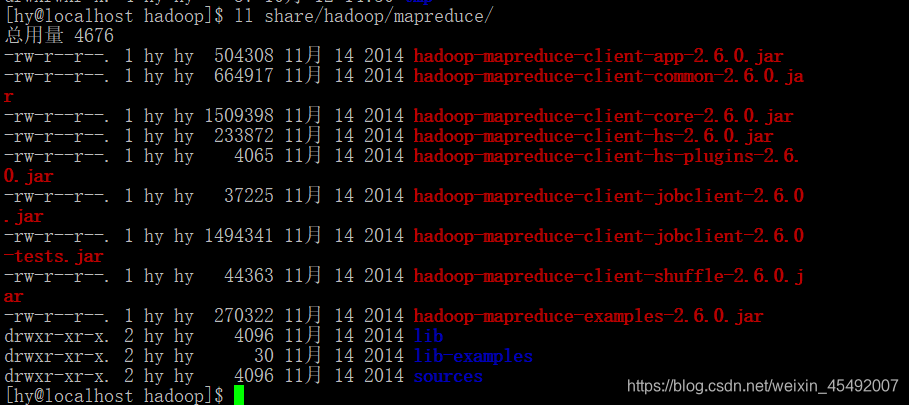

1.查看wordcount包

发现存在hadoop-mapredure-example.jar

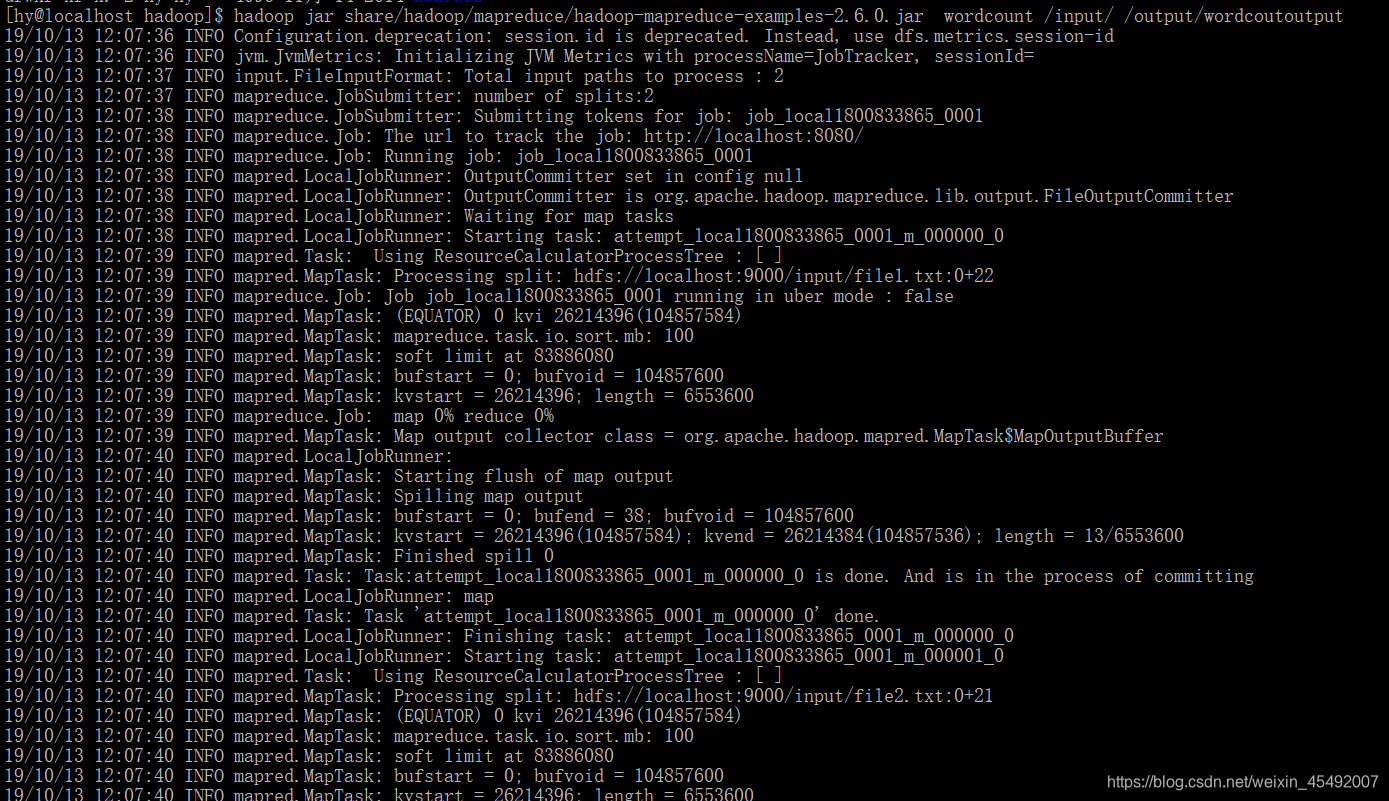

2.使用这个包执行wordcount

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-example.jar wordcount /input/ /output/wordcoutoutput

这行命令的意思是调用hadoop-mapreduce-example.jar这个jar包并使用wordcount方法,使用hadoop中的input文件中的内容,将结果输出到output中的wordcoutoutput文件中

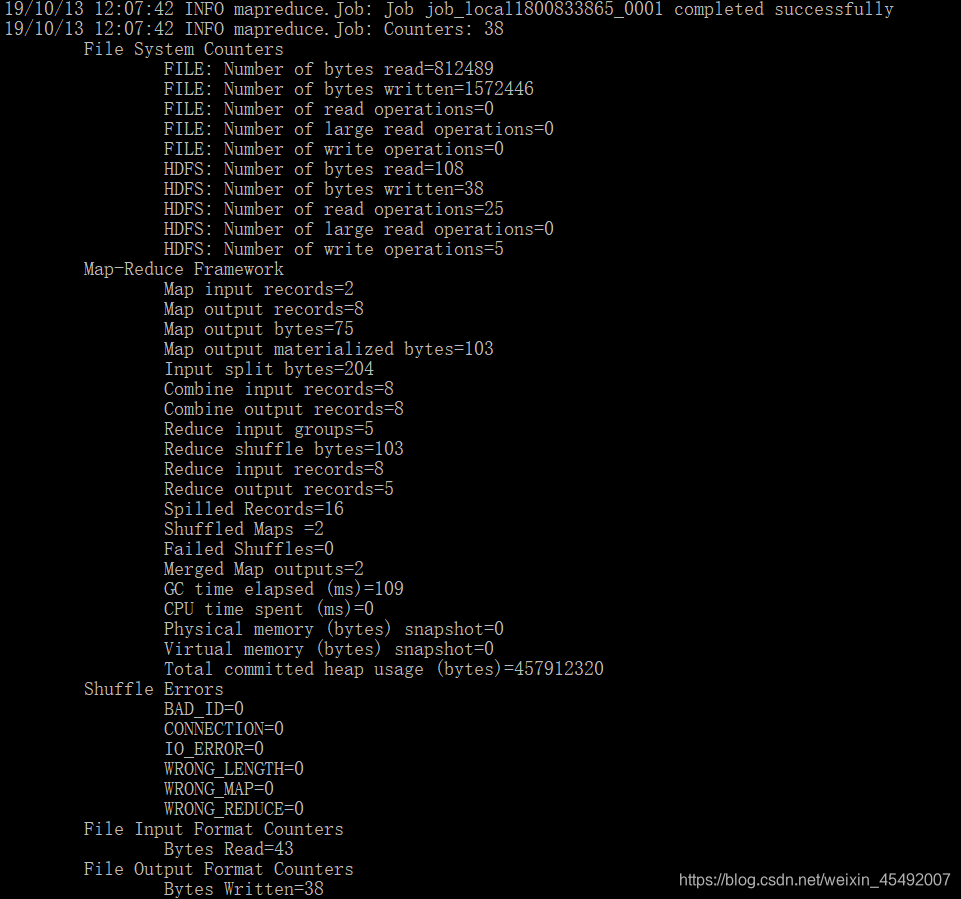

此时出现successful

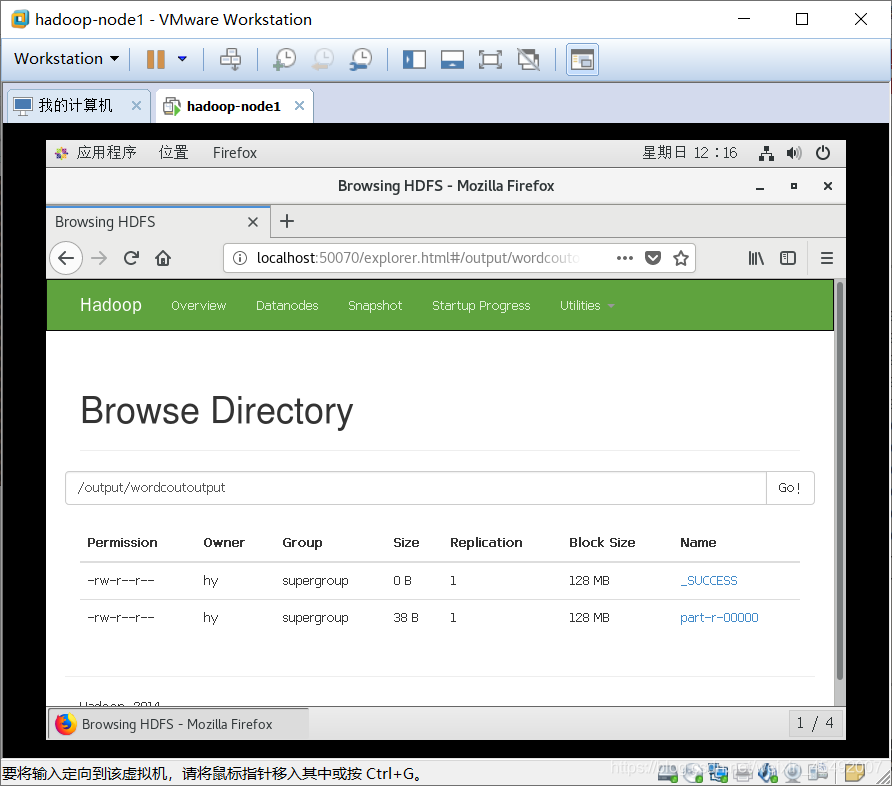

通过web查看使用wordcount生成的文件

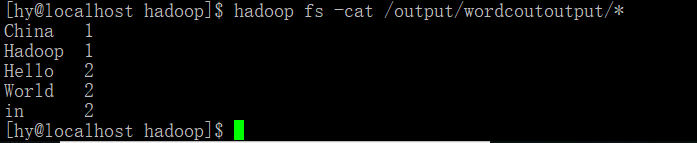

3.查看生成的结果:

结果使用hadoop中的wordcount程序成功!

5.总结

1.使用hadoop的执行操作文件的命令的时候需要使用hadoop fs -命令名称 操作,对于执行jar包需要使用hadoop jar XXX.jar的方式执行jar文件

2.通过hadoop fs -ls /查看根文件下的内容

3.通过 hadoop fs -mkdir /文件夹名 ,向hadoop中的根目录下创建文件夹

4.通过hadoop fs -put /本地文件名 /目标文件夹/,向hadoop中的目标问及那夹中添加本地路径的文件(就是向hadoop文件中推送本地文件)

5.通过hadoop jar XXX.jar wordcount /统计数据的指定的文件/ /输出结果的目标文件/,使用wordcout统计指定文件夹中的内容并输出到目标文件夹中

6.通过hadoop fs -cat /输出的目标文件/* 的方式查看最后统计的结果

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!