Transformer总结(2022版)

作者:Xavier Amatriain 翻译: 炼丹小生

很多人的“记忆”并没那么好,特别是对名字.这些年各种各样的transformer涌现出来,各有各的优势,但是他们的名字却不能直白的看出该版本的transformer到底做了什么.这篇的目的就是把所有流行的transformer进行清晰简单的分类,以便大家对transformer家族快速梳理。

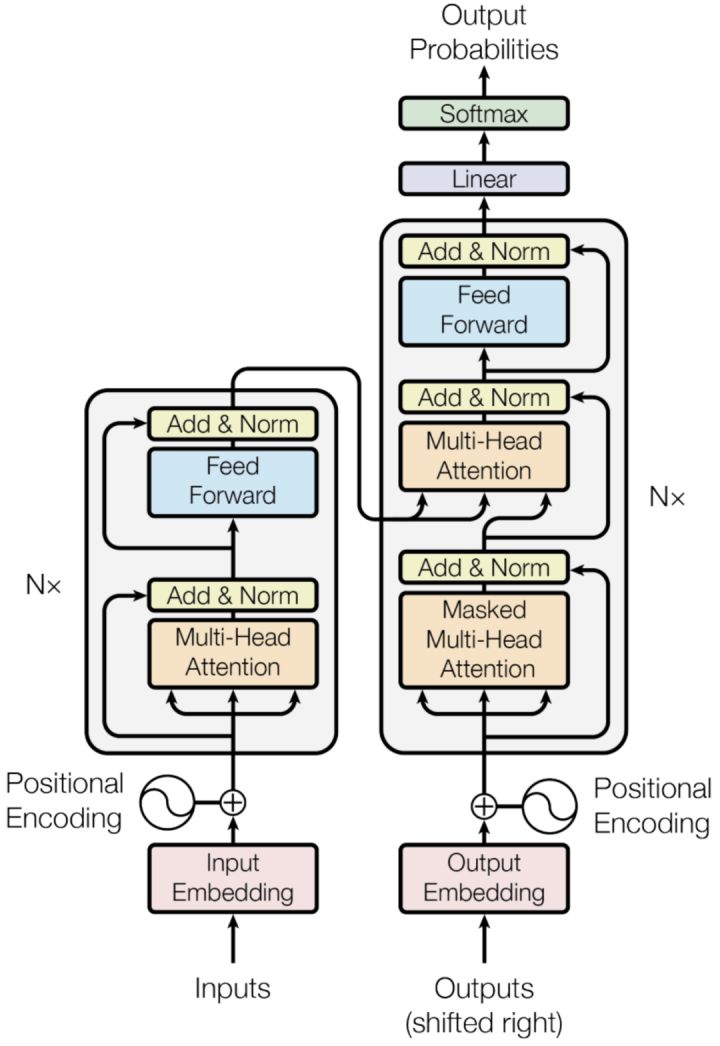

Transformer是什么就不用多说了,2017年开始至今引用量将近4w的论文

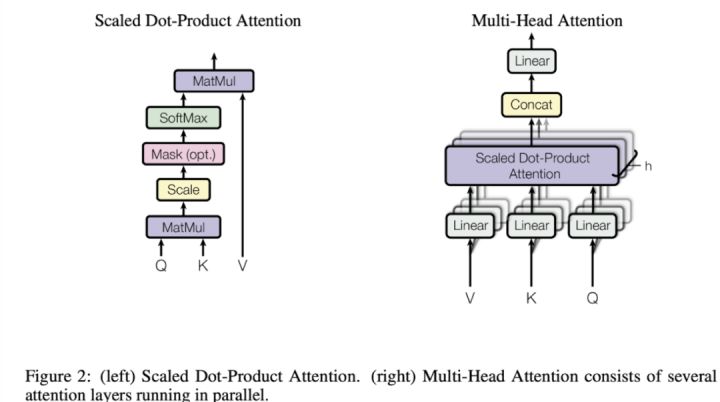

顺便温习一下最"核心"的multi-headed attention结构,该结构"匹配"query和key-value对,并且输出value的权重和,value的权重来自于query和key的attention值.Transformer结构使用了多头机制,并行计算特定的attention值,计算方式采用的是Scaled Dot-Product Attentio,如下图所示:

总结transformer主要由以下几个部分组成:

预训练架构: Encoder-Decoder

预训练任务:

- Language Modeling(LM) 预测下个token

- Masked Language Modeling(MLM) 完形填空

- Permuted Language Modeling(PLM) 对句子做排列

- Denoising Autoencoder(DAE): 句子中做随机采样,或者随机删除一些token,又或是打乱句子顺序,目标是恢复之前的输入

- Contrastive Learning(CTL): 各种对比学习方法

应用:问答、情感分析、实体识别等.

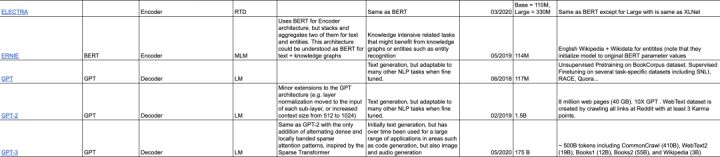

Catalog table

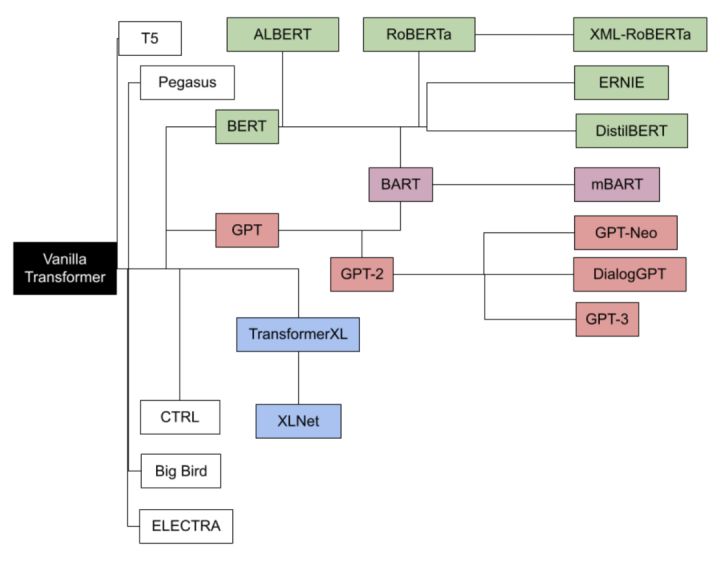

Transfromer族谱及时间线

参考文献

1.https://xamat.medium.com/transformers-models-an-introduction-and-catalogue-2022-edition-2d1e9039f376

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!