二、搭建Hadoop伪分布式(Liunx虚拟机)

1、更新apt

·使用Ctrl+Alt+T,唤出终端

代码:

sudo apt-get update 结果截图:

代码:

sudo apt-get install vim结果截图:

2、配置无秘登录ssh

安装 ssh 程序,输入如下命令sudo apt install ssh截图:

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa截图:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keysssh localhost截图:

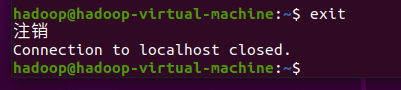

exit截图:

3、Java环境安装

卸载原版 jdk ,输入如下命令:sudo apt remove openjdk*将jbk的jar包复制到主目录

tar -xvf jdk-8u162-linux-x64.tar.gz

sudo mv jdk1.8.0_162 /usr/local/jdk

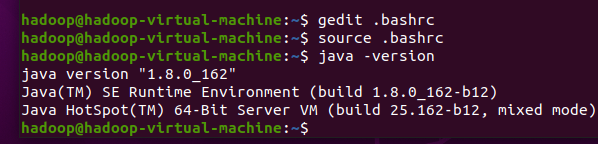

用户环境变量,使用gedit打开.bashrc文件, 输入如下命令:

gedit .bashrc弹出如下界面:

export JAVA_HOME=/usr/local/jdk

export PATH=$PATH:$JAVA_HOME/binsource .bashrcjava -version截图:

4、hadoop安装

将hadoop安装包复制到主目录

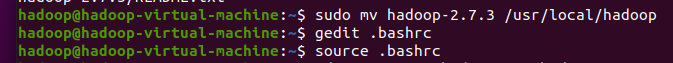

tar -xvf hadoop-2.7.3.tar.gzsudo mv hadoop-2.7.3 /usr/local/hadoopgedit .bashrcexport HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbinCtrl+s,然后点击右上角的小叉叉,关闭文件,输入:

source .bashrc截图:

5、配置hadoop

cd /usr/local/hadoop/etc/hadoopsudo gedit core-site.xml 清空文件内容,替换成如下:

清空文件内容,替换成如下: hadoop.tmp.dir /opt/hadoop A base for other temporary directories. fs.defaultFS hdfs://localhost/ The name of the default file system. A URI whose scheme and authority determine the FileSystem implementation. The uri's scheme determines the config property (fs.SCHEME.impl) naming the FileSystem implementation class. The uri's authority is used to determine the host, port, etc. for a filesystem. sudo gedit hdfs-site.xmlsudo gedit mapred-site.xml mapreduce.framework.name yarn The runtime framework for executing MapReduce jobs. Can be one of local, classic or yarn. 点击Ctrl+s,然后点击右上角的小叉叉关掉界面

编辑 yarn-site.xml 文件,这个文件主要是对 yarn 进行设置,输入如下命令sudo gedit yarn-site.xml The hostname of the RM. yarn.resourcemanager.hostname localhost A comma separated list of services where service name should only contain a-zA-Z0-9_ and can not start with numbers yarn.nodemanager.aux-services mapreduce_shuffle 点击Ctrl+s,然后点击右上角的小叉叉关掉界面

编辑 hadoop-env.sh 文件,设置 JAVA_HOME 环境变量,输入如下命令 :sudo gedit hadoop-env.sh 修改后:

修改后:  点击 Ctrl+s 保存,然后点击右上角小叉叉关闭界面 格式化 hadoop 系统

点击 Ctrl+s 保存,然后点击右上角小叉叉关闭界面 格式化 hadoop 系统 sudo mkdir /opt/hadoopsudo chmod -R a+w /opt/hadoophdfs namenode -format截图:

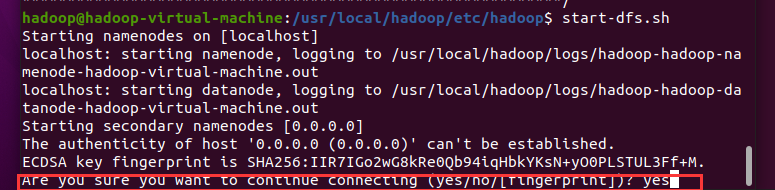

启动 hdfs ,输入如下命令:

启动 hdfs ,输入如下命令: cd ~start-dfs.sh第一次启动需要确定输入yes

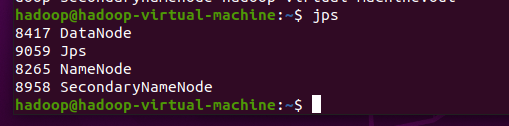

检查 hdfs 系统启动成功与否输入 jps 命令,如果有如下图所示的三个进程表示 hdfs 运行正常,否则表示有 问题。

检查 hdfs 系统启动成功与否输入 jps 命令,如果有如下图所示的三个进程表示 hdfs 运行正常,否则表示有 问题。 jps 启动 yarn ,输入如下命令 :

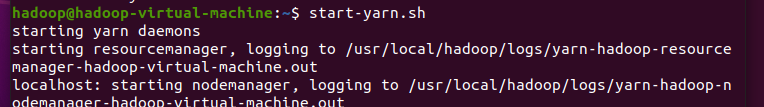

启动 yarn ,输入如下命令 : start-yarn.sh截图:

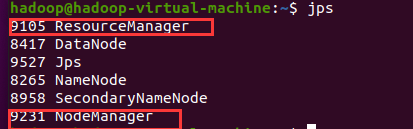

jps截图:

停止 hadoop 集群命令 :

停止 hadoop 集群命令 : stop-dfs.shstop-yarn.sh搭建结束。

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!