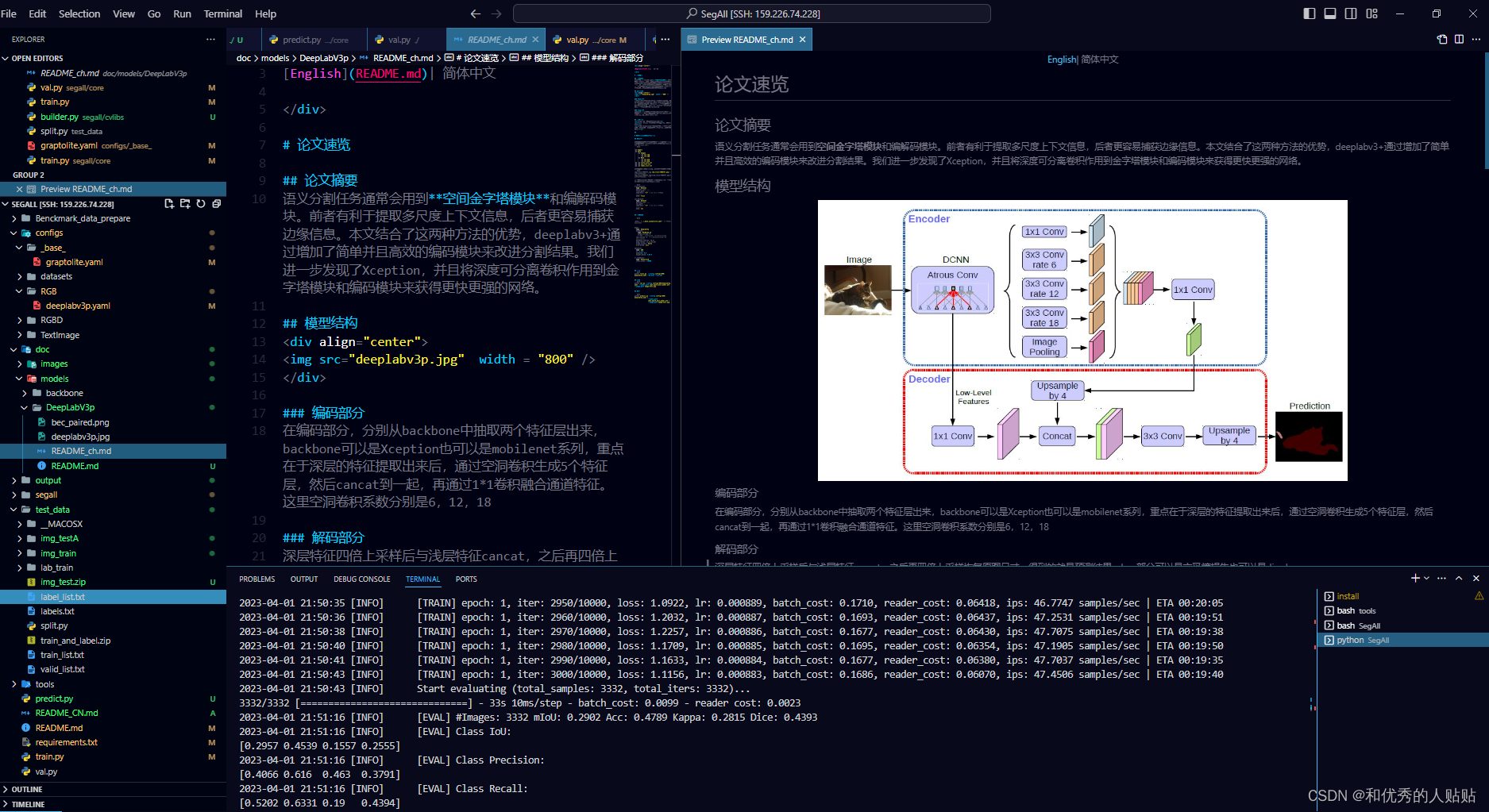

不写代码跑通基于U2Net的眼底视盘分割--Pytorch

项目总览

使用我开源的代码:GitHub - DianaNerualNetwork/SegAll

本代码是为了方便科研复现代码完成的基于Pytorch类似PaddleSeg的集成套件。经过添加模型文件以及修改yml文件即可开始训练,本仓库将不断更新,欢迎大家点击star关注~

数据介绍

数据来源

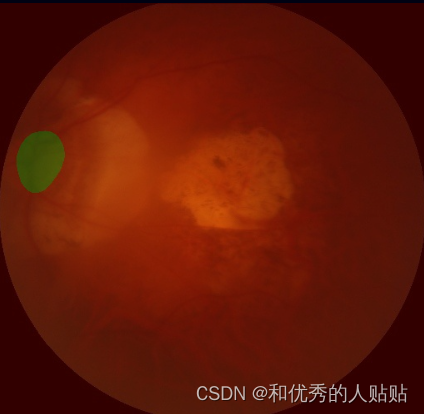

本项目数据集来源于中国广州中山大学中山眼科中心,数据集中包含 200 个 2D 眼底彩照样本,分别为:训练集 100 对,测试集 100 对(用于平台提交,无标注)。

【金标准制作的方法】

各样本的初始视杯视盘分割区域标注由中国中山大学中山眼科中心4名临床眼科医生手动完成。这4名医生在没有获得任何患者信息或数据中疾病流行情况的情况下,独立对图像中视盘和视杯区域进行勾勒。随后,4个初始标注结果汇总给任务二中的更高级医生进行融合。视杯视盘分割结果的融合采用多数投票的方式,融合医生检查初始的分割标注,并选择取哪几位医生标注结果的交集作为最终视杯视盘分割金标准。

【数据格式说明】

- 训练集和测试集的图像:100 个样本编号 0001-0100/0101-0200,JPG格式。

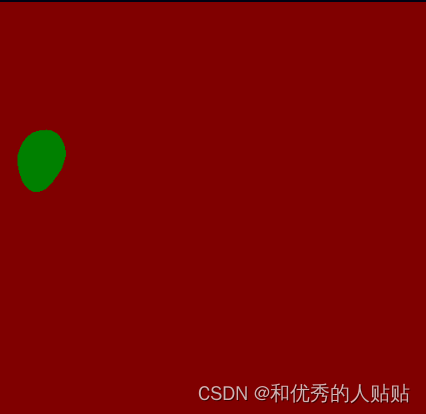

- 训练集的标注:100 个样本编号 0001-0100,PNG格式;其中的像素值对应关系为:0 - 视杯、128 - 视盘中非视杯区域、255 - 其他区域。

在运行下方的命令,准备数据,将自动在SegAll下建立data文件夹以及划分好的txt文件

bash Benckmark_data_prepare/RGB/MICCAI2021/disc_cpu.sh

项目实现过程

本项目已经内置了optic_disc的基础训练文件,关于读取OpticDisc数据集的配置文件在configs/_base_/optic_disc.yml,根据需要对train_dataset的预处理函数transforms做增添。

格式如下:

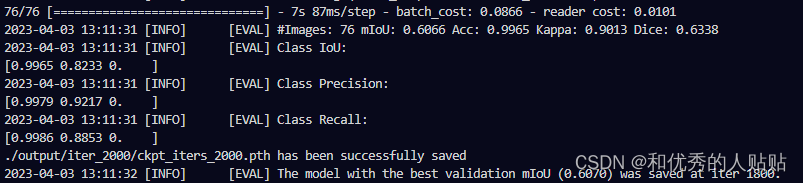

模型训练结果:

python train.py --config configs/RGB/U2Net/u2net.yaml --save_interval 200 --do_eval

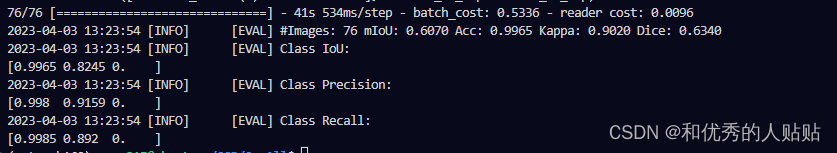

模型验证:

python val.py --config configs/RGB/U2Net/u2net.yaml --model_path .output/best_model/ckpt_iters_best_model.pth

模型预测:

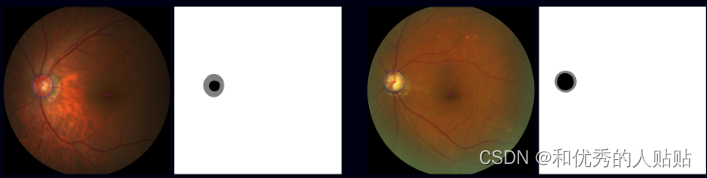

python predict.py --config configs/RGB/U2Net/u2net.yaml --model_path ./output/best_model/ckpt_iters_best_model.pth --image_path ./data/optic_disc_seg/JPEGImages/P0193.jpg2000iters模型预测结果:

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!