全连接层VS卷积层

1.全连接层:

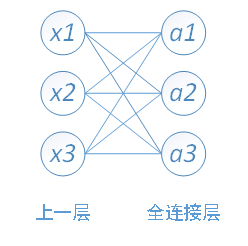

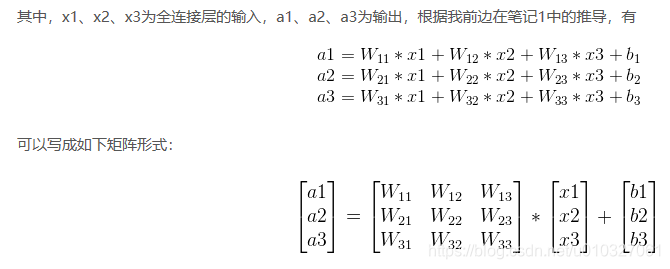

全连接层的每一个结点都与上一层的所有结点相连。类似下图:

2.卷积层:

参看:

卷积神经网络

反卷积/转置卷积 的理解 transposed conv/deconv

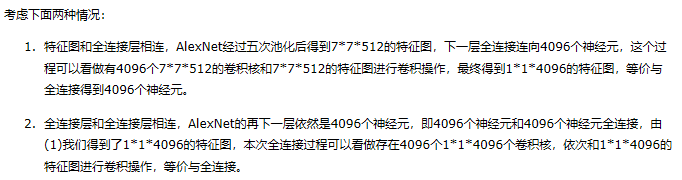

3.全连接层转化为卷积层

有兴趣的先看看Alexnet的网络结构。Tensorflow,Alexnet和MNIST数据 识别手写的数字(入门,代码,解析),此链接和本文的Alexnet参数不一致,因为处理的图片不一样。

example:

好处:

1. 卷积层可以多尺度,全连接层必须限制输入图像的大小。

example:

对于384*384的图片,不修改AlexNet的结构使之适应384*384(依然使用原来224x224输入的结构),直到经过汇聚层得到[12x12x512]的数组时,网络运行没有任何问题,按照原来的架构,接下来要将特征图平铺和4096个神经元全连接,这时候就出问题了,因为原架构平铺后是7x7,现在是12x12,无法使用之前的参数矩阵了,如果还需要使用全连接,需要修改全连接的权重参数。还有一种方法是将全连接层转化为卷积层后可继续进行,此时的卷积核小于图片尺寸大小,并最终得到6x6的正确输出,仅仅将网络的全连接层等价转化为卷积层,就能接收更大的图片,这显然方便了很多。

2.卷积层在某些情况下更高效。

面对384×384的图像,让(含全连接层)的初始卷积神经网络以32像素的步长独立对图像中的224×224块进行多次评价,其效果和使用把全连接层变换为卷积层后的卷积神经网络进行一次前向传播是一样的。

Evaluating the original ConvNet (with FC layers) independently across 224x224 crops of the 384x384 image in strides of 32 pixels gives an identical result to forwarding the converted ConvNet one time.

4. CNN和FCN

各人觉得,FCN是CNN的一种。CNN中有些网络包含全连接层,FCN网络中所有的层都是卷积层,故称为全卷积网络。

参考文献

https://blog.csdn.net/gyh_420/article/details/78569225

https://www.cnblogs.com/liuzhan709/p/9356960.html

https://www.cnblogs.com/gujianhan/p/6030639.html

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!