深度网络简单杂记

1*1卷积核的作用:升维降维,增加通道间的信息交互,增加非线性特性,替代全连接层

filter:表示卷积核,filter数量也就代表输出的深度.filter 卷积核奇数的原因是使图像两边可以对称padding。二是奇数的f有central pixel可以方便确定position

padding :‘SAME填充数不固定’.'VALID不填充''FULLMODE:填充数为k-1':

GAP(全局平均池化):一种替代全连接层的结构,对该层的每个特征图取均值,一个特征图对应一个特征点。特征点组成的特征向量进行softmax分类。(network in network)

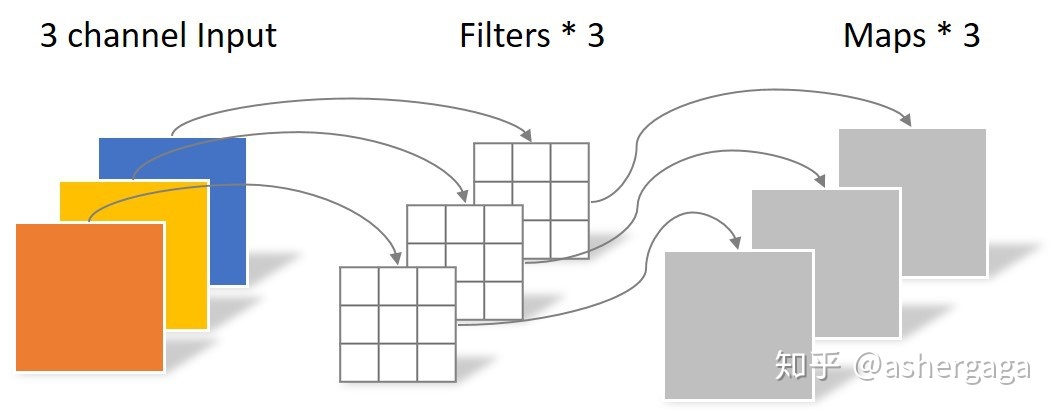

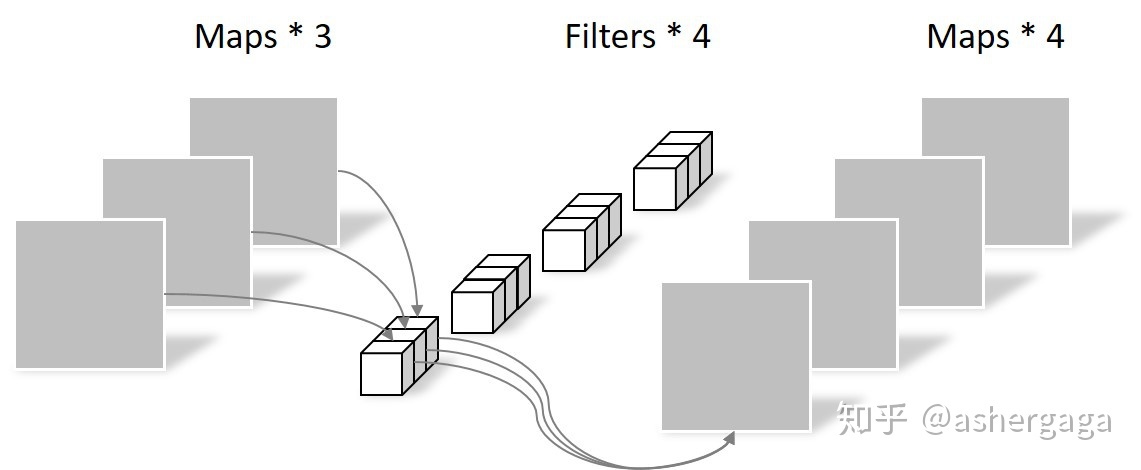

Depthwise Connvolution:与Pointwise 合起来被称为Depthwise Separable Connvolution.首先进行Dw ,filter的通道数为1,此时Dw完全只在单独的通道上进行计算。3通道输入经过Dw生成3通道输出,由于只在单通道上进行计算,因此会造成不同通道在相同位置上的信息丢失。Pw是在生成的map上进行1*1卷积的操作,联合不同通道之间的特征。降低参数(mobilenet)

上采样方法:插值法,反卷积,反池化

反卷积的棋盘效应:当卷积核的尺寸无法被步长整除时就会出现棋盘格现象,可以通过插值法改变图像尺寸,进行反卷积操作

Alexnet:更深的网络结构;打破卷积必池化的思维定式,使用层叠的卷积层,即卷积层+卷积层+池化层来提取图像的特征;多GPU训练;使用Dropout、Data Augmentation(随机裁剪)抑制过拟合;使用Relu替换之前的sigmoid的作为激活函数;引入LRN(局部响应归一化);重叠池化(stride小于核尺寸,使featuremap部分感受野重叠,减缓过拟合)

group connect(群卷积):(ALexNet)将通道分为两部分,各自进行卷积,最后进行contact

卷积层的物理意思理解:图像做卷积理解为两个向量点乘,响应越大,表示图像纹理与卷积核参数化的纹理越像,从这个角度来说,特征图可以表示纹理出现的位置,对于深层次的特征图,表示纹理的深层组合在原图的位置。网络学习的是纹理之间的相对位置而非精确位置,所有理论上下采样弱化精确范围,增加对特征几何变换的容忍性。全连接层作用,纹理多次卷积之后具有了语义,卷积层可以理解为在这组属性上,相同物体系数差别小,不同样本系数差别大,根据样本用这组属性来描述时的系数,来预测样本的语义内容。

Dropout缩放:keras中对输入向量进行缩放,也可以对权重进行缩放。在模型训练时,对输入向量(失活概率p)乘以1/1-p,保持期望不变。好处是测试阶段不再需要rescal。

过拟合表示模型在训练数据上损失函数较小,预测准确率较高,在测试数据上损失函数较大,预测准确率较低。

为什么能解决过拟合:1.随机的丢弃构造出不同的神经网络,相当于不同网络结果取平均2.减少神经元之间的相关性,迫使网络学习更鲁棒的特征,3.类似于生物进化的性别,不同的性别繁衍出适应新环境的变种

反卷积、转置卷积:反卷积一般用于上采样,转置卷积只是为了将图像恢复的原始大小,本质上是卷积的过程,需要重新学习参数。从信息论的角度,卷积过程丢失图像的细节信息,是不可逆的。

空洞卷积:扩大感受野,捕获多尺度的上下文信息

池化作用:增加不变性,提高模型的泛化能力,保留主要特征的同时降低参数计算量

池化层的反向传播:将梯度按照池化的机构分配,总体不变

1.常用的normalization方法:

BN:

LN:规范化一层的输入,计算该层的平均输入值和方差(RNN)

WN:将权重分解成大小g和方向v两个参数,然后分别使用SGD优化两个参数.

CN(Cosine Normalization):理解:WN 用 权重的模对输入向量进行 scale,而 CN 在此基础上用输 入向量的模对输入向量进行了进一步的 scale

2.attention详解:

attention和self attention 其具体计算过程是一样的,只是计算对象发生了变化而已。attention是source对target的attention,而self attention 是source 对source的attention

self-attention:,multihead attetion也就是,qkv矩阵多维

transformer: selfattention encode-decode attention LN,残差、position Embedding\mask

Vit 与swin-transform区别:shift window attention:图像的patch通过shift,提升模型感受野

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!