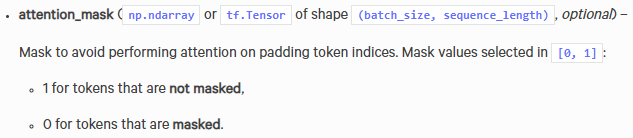

attention_mask:避免用注意力机制的时候关注到填充符(翻译可能不准,大致这个意思)

参考链接:https://huggingface.co/transformers/model_doc/bert.html?highlight=tfbertmodel%20from_pretrained#tfbertmodel

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!