Python Scrapy 爬虫踩过的坑(一)

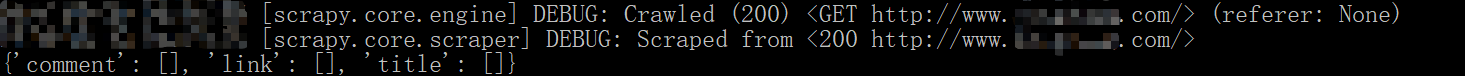

一、DEBUG Crawled 200 ,具体报错信息如下图所示:

爬虫初学者,记录自己曾爬过的坑。

1. 200为HTTP 状态码,代表访问OK。

2. 但是设置的正则的返回的爬取信息为[]

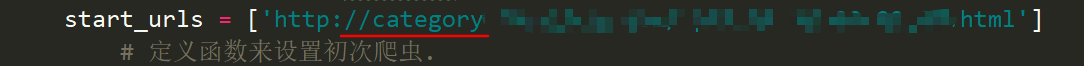

3. 主要出错原因,爬取的为分类下的数据信息,start_urls = [ ] 为设置爬虫文件时 域名所对应的网址。需要修改为分类下的网站。才能爬取数据成功。

https://stackoverflow.com/questions/32190222/scrapy-debug-crawled-200

也有可能是正则表达式的设置出错+JS界面的原因

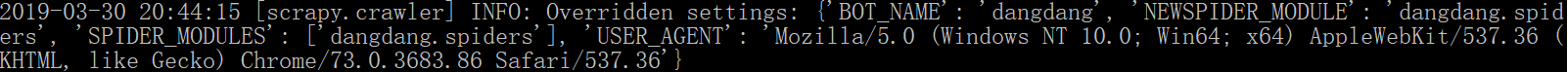

二、Overridden setting

主要报错信息如下图所示:

创建爬虫文件的时候,scrapy genspider -t crawl file_name domain_name 采用了crawl模板,setting.py 已配置了相关的访问信息。USER_AGENT字段的设置与file_name(爬

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!