《KG-BERT: BERT for Knowledge Graph Completion》

文章地址:https://arxiv.org/pdf/1909.03193.pdf?ref=https://githubhelp.com

文章目录

- 文章内容

- 文章模型

- 预测三元组的合理性

- 关系预测

- 文章总结

文章内容

针对于知识图谱完整性的判断任务,作者将知识图视为一个三元组<头实体,关系、尾实体>文本序列,并且提出了一个全新的知识图双向Transformer编码框架(KG-BERT)来对这些三元组进行建模。这也是首次将预训练语言模型用于知识图谱当中。

文章模型

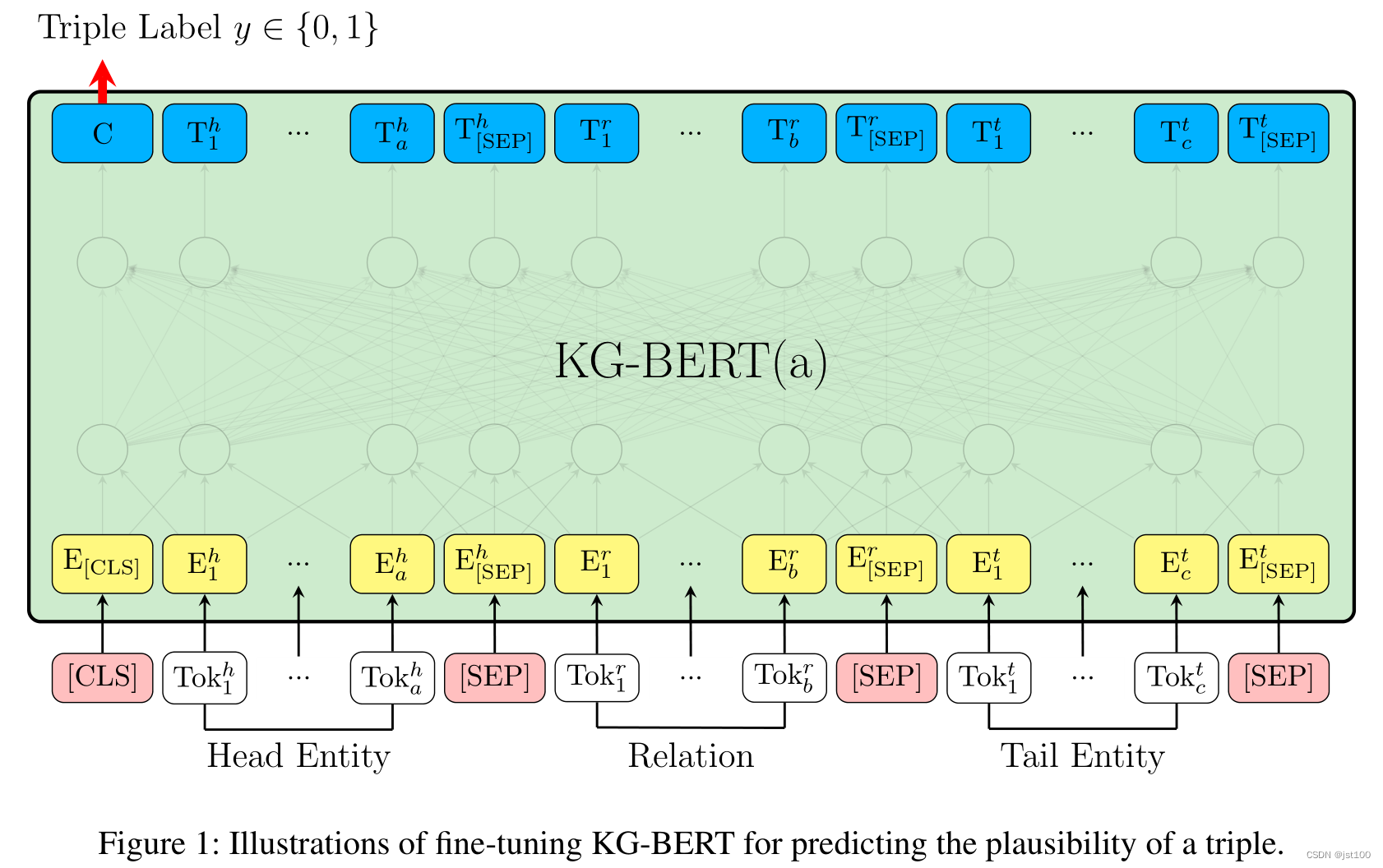

预测三元组的合理性

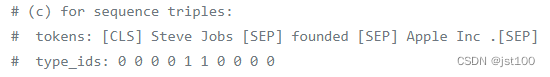

针对三元组的合理性判断问题,作者提出的模型框架如上图所示,处理方式比较简单,也就是将头实体、关系和尾实体中间用BERT特殊token"[SEP]"分隔开,具体示例如下图所示:

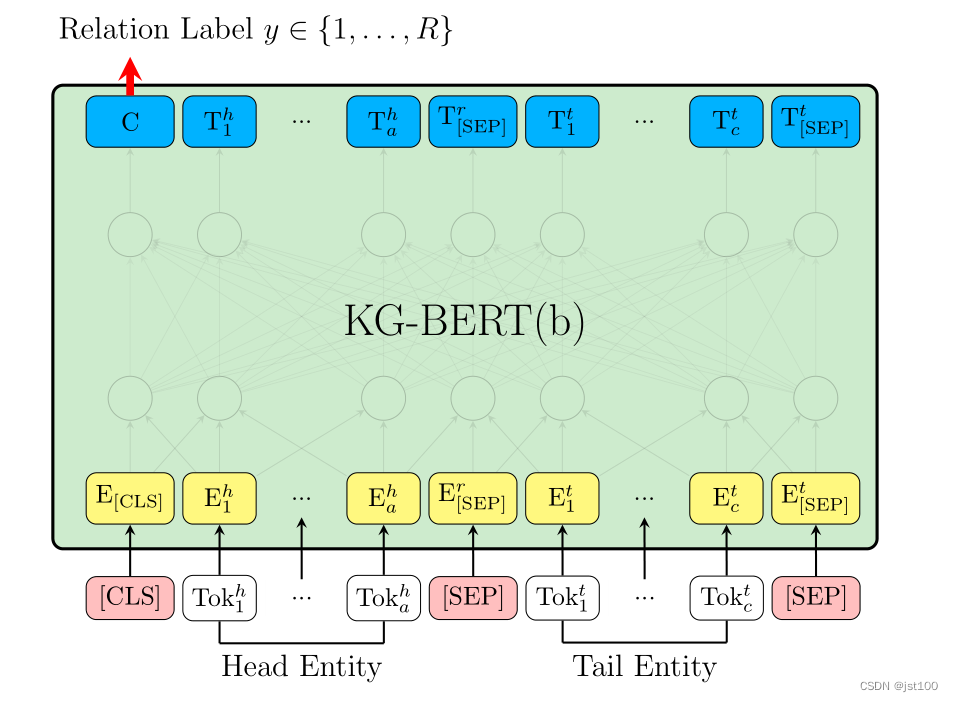

关系预测

作者对于两个实体之间关系的预测也比较简单,也就是将两个实体用"[SEP]"分隔开即可,具体如下图所示:

文章总结

在现在看来这篇文章的思想较为简单,也就是运用预训练语言模型自身的优势,将三元组用“[SEP]”分隔开再输入到模型当中进行训练,当然这也可以将知识图转化为文本训练从而可以更适用于预训练语言模型的输入。

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!