编写一个属于自己的DPDK应用程序(DPDK入门向)

编写一个属于自己的DPDK应用程序(DPDK入门向)

- 1.前言

- 2.DPDK 的示例 examples

- 3.helloworld

- 4.以skeleton(basicfwd)为基础,编写自己的应用程序。

- 5.依葫芦画瓢+抛砖引玉

- 6.编译自己的应用程序

- 7.总结

1.前言

最近这几周在研究dpdk,测试性能,因为是从零开始需要找各种各样的资料,然后发现要自己编写一个dpdk应用程序,真正对自己帮助最大的还是官方的文档,一个是api文档,一个是gudides文档(http://doc.dpdk.org/api https://doc.dpdk.org/guides)。毫无疑问的全是英文文档,基本需要借助网页翻译连猜带蒙。

作为程序员这应该是基本技能了,而我写这篇文章的目的,一是对自己这段时间的研究成果做一个积累,二是希望帮助大家更快的上手dpdk,编写一个dpdk应用程序。

2.DPDK 的示例 examples

dpdk的下载,安装和使用直接百度就有很多的教程,跟着教程来应该问题不大,这里主要提醒大家注意dpdk给出的示例

这里面有dpdk大部分的应用场景,想要详细了解可以去guides网页(前文有网址),像二层转发 三层转发(l2fwd l3fwd)网上很多测试性能都是用的这两个例子,而我主要介绍 helloworld basicfwd这两个例子 和 testpmd的结合,编写一个发包的dpdk应用程序,主要还是分享开发流程。

3.helloworld

这个代码并不复杂,我们主要关注四个地方:

rte_eal_init();

这个函数初始化dpdk EAL环境抽象层,这是所有的dpdk应用程序都会使用到的通用模块,想要具体了解的话可以阅读guides文档,在开发过程中一般是首先需要被调用的。

RTE_LCORE_FOREACH_SLAVE();

这个宏应该比较好理解,就是一个for循环,遍历所有的slave核(只有一个master核,其余是slave核,比如一个4核cpu,0核为master核,1、2、3为slave核)。

rte_eal_remote_launch();

这个函数功能也很简单,真要类比的话类似于多线程或者多进程的函数,它相当于另开了一个线程或者进程去执行lcore_hello(自定义的函数),只不过它使用另一个核去完成。第二个参数是传给自定义函数的参数。

除了rte_eal_remote_launch(),还有一个rte_eal_mp_remote_launch(),这个函数不需要遍历,直接会调用所有的核去执行我们自定义的函数。

rte_eal_mp_wait_lcore();

看到wait就应该心里有数了,这个是在等待所有核core结束。这里依然有一个rte_eal_wait_lcore(…,core_id)函数,等待对应核结束,实际上rte_eal_mp_wait_lcore内部应该是让每一个核执行rte_eal_wait_lcore()来实现的。

4.以skeleton(basicfwd)为基础,编写自己的应用程序。

通过对helloworld示例的介绍,最主要的是掌握了类似于多线程或者多进程的rte_eal_remote_launch(),下面是basicfwd的源码,它只使用了一个核,但是我们使用的时候,可以通过rte_eal_remote_launch()增加核来处理自己的业务。

/* SPDX-License-Identifier: BSD-3-Clause* Copyright(c) 2010-2015 Intel Corporation*/#include 在这个示例中,可以看到基本的开发流程:

rte_eal_init()

argc -= ret;

argv += ret

开头三连是为了区分eal环境层参数和自己定义的参数,basicfwd没有自定义参数,但我们自己可以在argv += ret;之后封装一个函数解析自定义参数 ,比如parser_my_dpdk(argc, argv),然后使用的时候通过 – 隔开,格式为 (eal 参数)-- (自定义参数)。

rte_eth_dev_count_avail()

这个函数获取设备的port数量,熟悉dpdk的应该都了解,dpdk中的port指的是设备的网口,即eth1、eth2、eth3等,和tcp/ip协议中的8080等端口不是一个东西。

rte_pktmbuf_pool_create()

创建一个内存池,basicfwd中的内存池是用来做接收数据包的缓存,我们可以在自己的程序中沿用,但是它并没有给发送数据包设置缓存,我们其实可以自己加上。

RTE_ETH_FOREACH_DEV()

这个宏应该也好理解,循环遍历port网口(你将几个port拖给dpdk管理,这里就执行几次)

port_init()

这是basicfwd定义的一个函数,它将port也就是网口的初始化进行了一层封装(如果不对网口做一些特殊设置,这个函数可以直接复制到我们的程序中作为自己的port网口初始化函数)。看它都干了些啥:

-

rte_eth_dev_info_get()

这个函数直接获取了当前网口的信息,具体有哪些信息,可以去api网址(文章开头)搜索rte_eth_dev_info这个结构体。 -

if (dev_info.tx_offload_capa & DEV_TX_OFFLOAD_MBUF_FAST_FREE)

port_conf.txmode.offloads |=

DEV_TX_OFFLOAD_MBUF_FAST_FREE;

这个宏是看网口设备是否支持mbufs快速释放的功能,支持的话就给默认加上。offload这个词是卸、减负的意思,一搬如果网口能够支持某些功能,就能够通过设置将cpu的相关工作卸载到port网口上,提高一些效率。 -

rte_eth_dev_configure(port, rx_rings, tx_rings, &port_conf)

这个函数是配置port网口的一些参数,rx_rings/tx_rings是你要设置的接收/发送的队列数目,这个要看自己的网口支持多少队列(cat /proc/interrupts),port_conf的具体设置可以去api网页查看rte_eth_conf这个结构体,可以重点关注一下 rte_eth_rxmode , rte_eth_txmode这两个成员。 -

rte_eth_dev_adjust_nb_rx_tx_desc(port, &nb_rxd, &nb_txd)

这个函数是去判断port网口的队列是否支持 nb_rxd/nb_txd个接收/发送 描述符,如果不支持那么多会自动调整到边界个数(如果没有这一层,很可能出现段错误)。 -

rte_eth_rx_queue_setup(port, q, nb_rxd, rte_eth_dev_socket_id(port), NULL, mbuf_pool)

命名中就可以看出,这个函数为port网口设置接收队列,因为我们之前设置了rx_rings=1,因此for循环只执行一次,q(queue_id)=0,设置一个接收队列(这个可以根据自己的实际情况来);

rte_eth_dev_socket_id返回的是一个NUMA结构套接字,所谓的NUMA结构是将多台服务起连接起来当做一台使用的技术,是多CPU模式的,如果自己的服务器只有一个CPU,这个参数可以就这么写不管它;

NULL这里其实可以填一个rx_conf,对应之后的tx_conf,这里直接默认为NULL;

mbuf_pool是basicfwd在main中用rte_pktmbuf_pool_create()创建出来的内存池,作为接收数据包的缓存。 -

rte_eth_tx_queue_setup(port, q, nb_txd,

rte_eth_dev_socket_id(port), &txconf)

这个函数为port网口设置传输发送队列,比上面的rte_eth_rx_queue_setup()少一个内存池参数,这个参数会为nb_rxd个连续的描述符初始化一块内存,因此发送队列其实是没有缓存区的,需要我们自己实现(也可以不实现)。 -

rte_eth_dev_start()

这个函数没啥好说的,port网口配置完了,直接start启动起来 -

rte_eth_promiscuous_enable(port)

这个是设置port网口的混杂模式,只要是到这个网口的数据包,不管是不是发给它的都会接受。

lcore_main

通过port_init的设置,我们基本上已经准备好了port网口,接下来就是需要处理的业务逻辑,basicfwd核心业务逻辑就只有两个函数:

rte_eth_rx_burst()函数负责接收数据包;

rte_eth_tx_burst()函数负责发送数据包;

如果发送有丢包,没发全,就将没发送出去的包rte_pktmbuf_free()掉。

其实在真实的应用场景中发送失败大多是不会rte_pktmbuf_free()的,而是接着发送。

同时,basicfwd中只使用了一个核去处理数据包的接收和发送,都2020年了,我们的电脑,服务器怎么也有4核以上了吧,土(败)豪(家)一点的可以直接使用rte_eal_remote_launch()函数,一个核接收rte_eth_rx_burst(),一个核处理数据包(自定义函数),一个核发送rte_eth_tx_burst(),甚至还能剩个核做其它(笑),就是这样做的话,数据的同步共享需要花点功夫,推荐使用dpdk的rte_ring无锁队列结构。

5.依葫芦画瓢+抛砖引玉

我自己写了一个dpdk的程序,根据MAC地址来实现专门的发包模式。

起因是这样的:刚开始我使用了testpmd程序的txonly(转发模式),不管怎么调试(修改了队列数,分组包数目,核心数目,数据包大小等),性能一直上不去(距离网口理论性能差了很多),然后想着使用pktgen-dpdk试一下发包,网上看了下pktgen的编译,发现不是很复杂,然后下载了源码自己编译,但事实证明我还是太年轻了!!(是哪个博客上写的能编译dpdk就能编译pktgen!!!那么多坑胃口好全吃了?!)

首先是准备环境,cmake,meson+ninja,要安装meson的话python至少3.5,GCC版本也最好升级,然后还有些莫名其妙的报错就不说了,像准备libdpdk什么的,这些我去pktgen的GitHub上才找到解决,然而好多博客教程上提都不提一句。

总之这都是题外话了,也正是这番遭遇让我开始自己写一个发包程序,参照testpmd的txonly.c源码,结合上面提到的basicfwd的开发流程,不多说,直接上源码:

/* SPDX-License-Identifier: BSD-3-Clause* Copyright(c) 2010-2014 Intel Corporation*/#include 可以很明显的看出,我就是直接借鉴的(理直气壮),甚至连注释都没改,毕竟是真的好用,唯一有区别的地方就是业务处理部分lcore_main(这也是大家根据自己的需求来处理的部分,我直接参照txonly.c来写的):

我直接写死了两个MAC地址,一个是src_mac,一个是dst_mac,然后将它copy到pkt中,用一个内存池来做缓存,一组发送512个数据包,如果发送失败会retry重新发送。

6.编译自己的应用程序

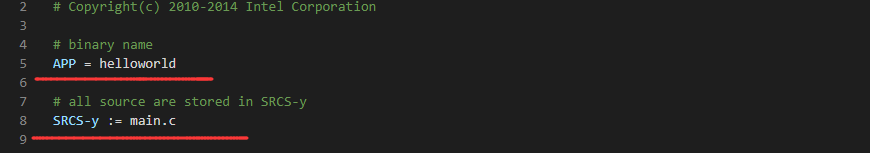

程序代码写完之后就是编译,当然可以使用GCC,但是会有一定难度,这边推荐官方最简单粗暴的方法,直接复制黏贴examples里面的Makefile文件到你的项目中,make编译,当然需要修改一下:

一般只要修改这两个地方就行,简单易懂。

7.总结

老实说dpdk的接口在api网址都有很详细的介绍,找到对应的功能模块之后就能根据自己的需要合理的添加到上述的流程框架中,之后无非就是写BUG,解BUG的循环煎熬

作为入门向的文章,可能只能帮助大家到这里了,毕竟我也还在学习中,长路漫漫,少侠一路好走。

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!