百度飞桨PaddlePaddle深度学习心得分享

能参加到这次的百度飞桨七日“Python小白逆袭大神”打卡营是一次偶然的了解得知的这个机会,之前因为课程和基础不够扎实参加到AI实战营没有顺利跟完全程,这一次很开心可以顺利跟上并且结营。下面的内容就简要的总结一下这几天的学习内容和踩过的小坑吧。

本次课程的课程目标:

1.掌握Python的基础语言、进阶知识和常用的深度学习库,能够利用Python爬取数据并进行可视化分析

2.掌握人工智能基础知识、应用,体验人工智能的前沿技术

3.了解飞桨平台及百度AI技术、应用,掌握AI Studio的使用方法

本次课程的安排:

- Day1-人工智能概述与python入门基础

- python基础、人工智能概述

- Day2-Python进阶

- python进阶学习和深度学习实践

- Day3-人工智能常用Python库

- 深度学习常用Python库介绍

- Day4-PaddleHub体验与应用

- PaddleHub体验与应用——《青春有你2》五人识别

- Day5-EasyDL体验与作业发布

- EasyDL体验与综合大作业

- Day6-PaddleHub创意赛发布

- Day7-课程结营

Day1-人工智能概述与python入门基础

python基础、人工智能概述

第一天的学习是对于python语言和人工智能的一个简单介绍,这部分对于没有什么基础的小白来说还是很友好,实验上应该也比较简单,没有遇到什么大问题,就直接上代码:

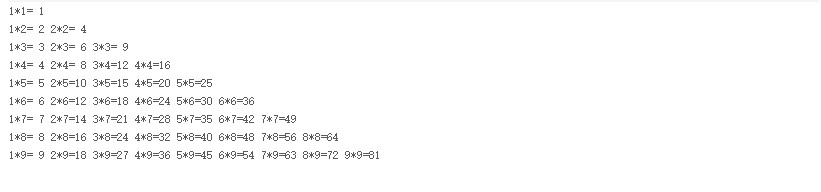

- 输出 9*9 乘法口诀表:

def table():for i in range(1,10):for j in range(1,i+1):print("{}*{}={:2} ".format(j,i,i*j), end='')print('')

if __name__ == '__main__':table()

- 查找特定文件名称:

#导入OS模块

import os

#待搜索的目录路径

path = "Day1-homework"

#待搜索的名称

filename = "2020"

#定义保存结果的数组

result = []def findfiles(path):#在这里写下您的查找文件代码吧!global indexli=os.listdir(path)for p in li:tempPathName=ppathname=os.path.join(path,p)if os.path.isdir(pathname):findfiles(pathname)elif os.path.isfile(pathname):if(tempPathName.find(filename)!=-1):index=0index=index+1result=[]result.append(index)result.append(pathname)if(len(result)>0):print(result)if __name__ == '__main__':findfiles(path)

Day2-Python进阶

python进阶学习和深度学习实践

这次实践使用Python来爬取百度百科中《青春有你2》所有参赛选手的信息,对于小白来说可以上手稍微有一点点难度,但跟着课程老师的思路和讲解还是可以克服困难的

爬虫的过程:

1.发送请求(requests模块)

2.获取响应数据(服务器返回)

3.解析并提取数据(BeautifulSoup查找或者re正则)

4.保存数据

一、爬取百度百科中《青春有你2》中所有参赛选手信息,返回页面数据

import json

import re

import requests

import datetime

from bs4 import BeautifulSoup

import os#获取当天的日期,并进行格式化,用于后面文件命名,格式:20200420

today = datetime.date.today().strftime('%Y%m%d') def crawl_wiki_data():"""爬取百度百科中《青春有你2》中参赛选手信息,返回html"""headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'}url='https://baike.baidu.com/item/青春有你第二季' try:response = requests.get(url,headers=headers)print(response.status_code)#将一段文档传入BeautifulSoup的构造方法,就能得到一个文档的对象, 可以传入一段字符串soup = BeautifulSoup(response.text,'lxml')#返回的是class为table-view log-set-param的所有标签tables = soup.find_all('table',{'class':'table-view log-set-param'})crawl_table_title = "参赛学员"for table in tables: #对当前节点前面的标签和字符串进行查找table_titles = table.find_previous('div').find_all('h3'

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!