MongoDB去除重复数据(只保留一个)

目录

直接对数据库进行操作

使用py进行去重

成功截图编辑

一个实例

集合结构

查询代码

直接对数据库进行操作

db.getCollection("你的集合名").aggregate([{

//使用aggregate聚合查询重复数据

//$group中是查询条件,根据你的字段来聚合相同的数据;

//$count用来统计重复出现的次数, $match来过滤没有重复的数据;

//$addToSet将聚合的数据id放入到dups数组中方便后面使用;$group:{_id:{你的字段1:'$你的字段1',你的字段2:"$你的字段2"},count:{$sum:1},dups:{$addToSet:'$_id'}}},{$match:{count:{$gt:1}}}]).forEach(function(it){//保留第一个数据,防止所以重复数据全部被删除it.dups.shift();//执行删除 db.getCollection("wallhaven.cc").remove({_id: {$in: it.dups}});});使用py进行去重

from pymongo import MongoClient# 打开集合 client = MongoClient(address, port) db = client.db_name collection = db.collection_namepatents = [] # 存储已遍历过的字段 count = 0 for item in collection.find():if item['你的字段'] not in patents: # 判断当前文档是否在之前已经遍历过patents.append(item['你的字段']) # 该文档设置成已遍历else:collection.delete_one(item) # 删除重复文档

成功截图

一个实例

集合结构

查询代码

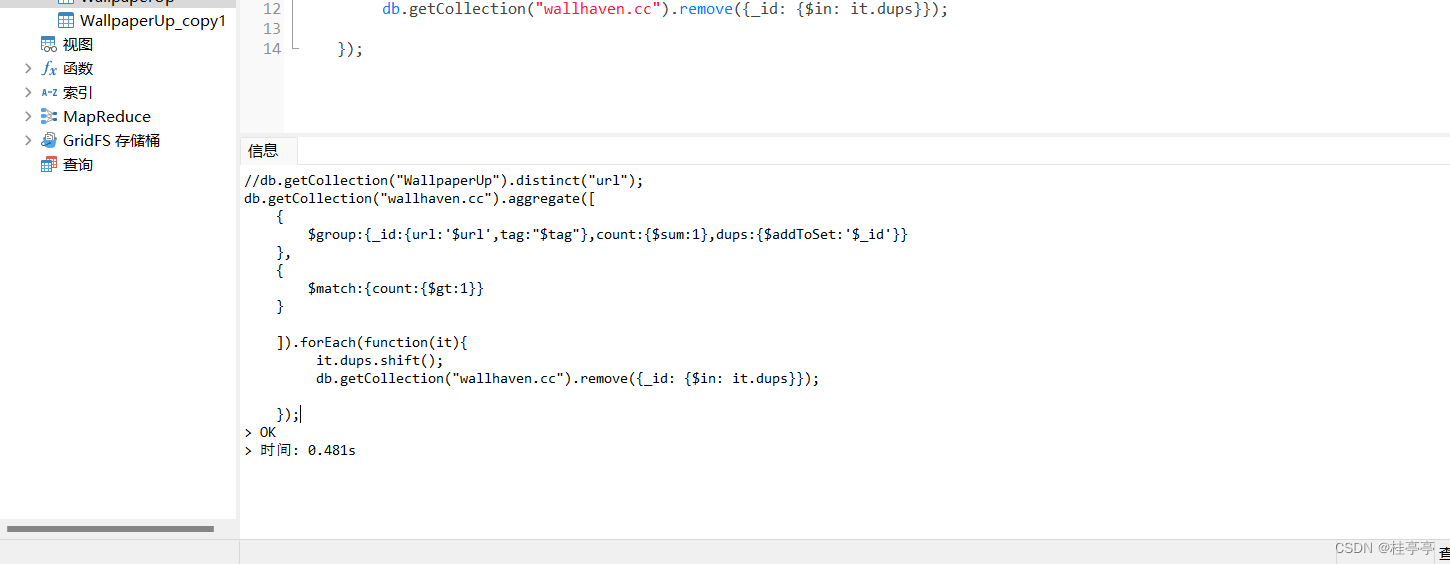

db.getCollection("wallhaven.cc").aggregate([

{

$group:{_id:{url:'$url',tag:"$tag"},count:{$sum:1},dups:{$addToSet:'$_id'}}

},

{

$match:{count:{$gt:1}}

}]).forEach(function(it){

it.dups.shift();

db.getCollection("wallhaven.cc").remove({_id: {$in: it.dups}});});

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!