【GPT3】Language Models are Few-Shot Learners

Paper Link: Language Models are Few-Shot Learners

GPT系列文章解读:

【GPT】Improving Language Understanding by Generative Pre-Training

【GPT2】Language Models are Unsupervised Multitask Learners

Abstract

在大规模文本语料上的预训练模型,然后在特定任务上微调后的NLP任务已经取得了长足的进步。然而针对任务无关的的模型结构,这种方法仍然需要在特定任务的成千上万的数据集上微调。对比来看,人类仅从少部分样本或简单的命令上,就可以学习新的语言任务。这里,我们极大程度地扩展语言模型,进而提高在通用任务、小样本上的性能,甚至可以比拟之前经过微调后的sota模型性能。具体地,我们训练了GPT-3的自回归语言模型,由1750亿个参数组成,10倍于之前的非稀疏语言模型。针对所有任务,GPT-3不用梯度更新或微调。仅仅通过任务和少量的说明信息就可以和模型交互。GPT-3在很多NLP数据集上都取得了很强的表现,包括:翻译、问答、完形填空以及即时推理、领域迁移、译码、三位数运算等。最后,GPT-3可以生成文章,人类很难区分是否由人撰写的。

Introduction

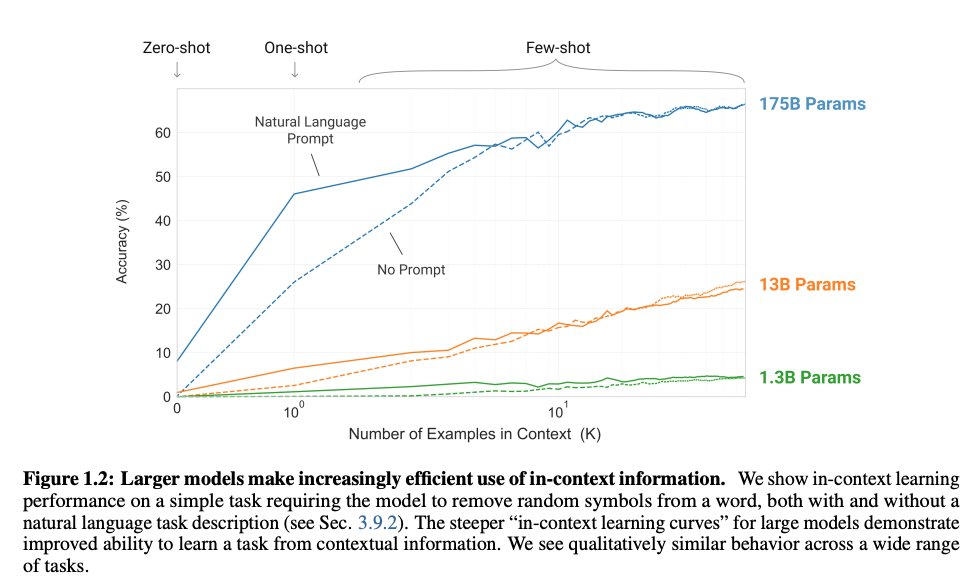

模型性能随着任务描述以及上下文示例的个数的增加而提升。尽管在某些任务上的结果仍然一版,但大模型以及语境中的示例提升这种趋势适用于大多数任务。另外强调一点,下图的学习曲线不涉及任何的梯度更新和微调,仅仅是增加了示例的个数。

Approach

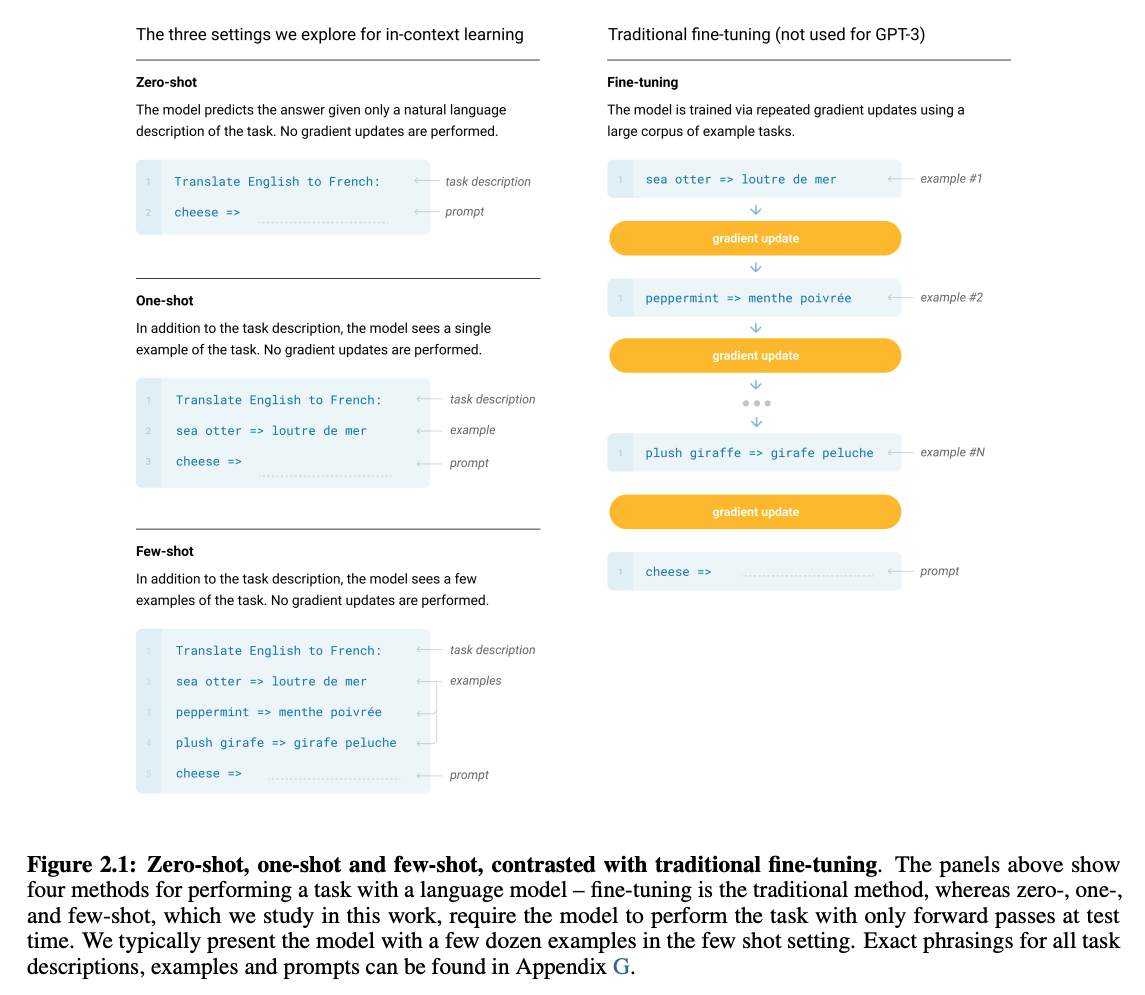

GPT-3将下游任务类型划分为4个类别:

- Fine-Tuning

- Few-Shot

- One-Shot

- Zero-Shot

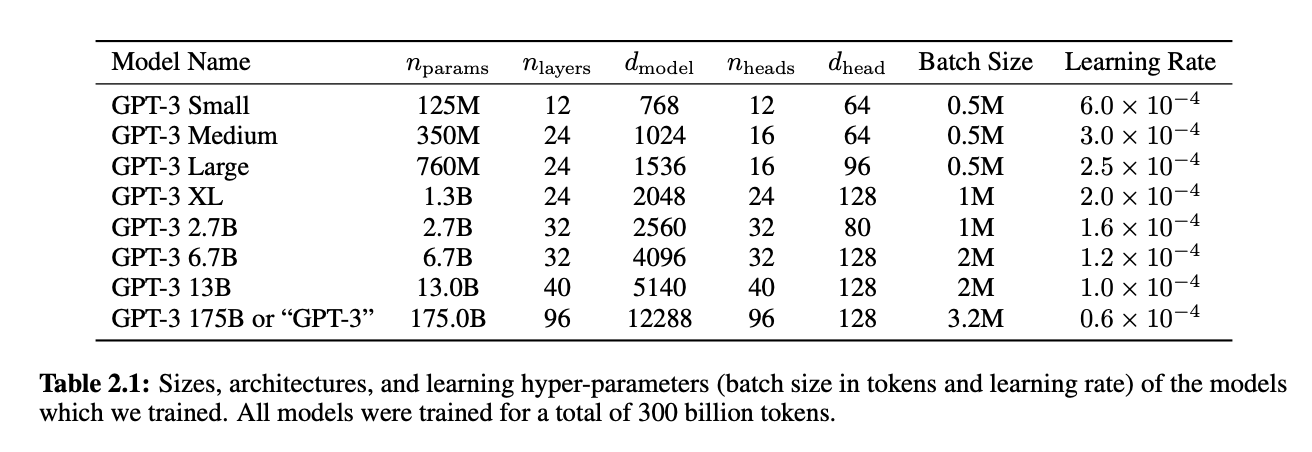

Model and Architectures

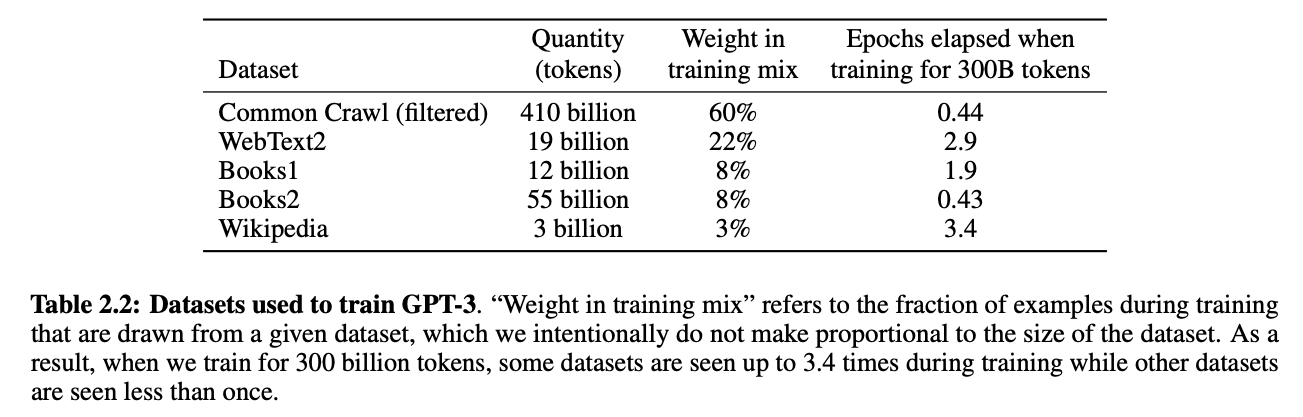

Training Dataset

Results

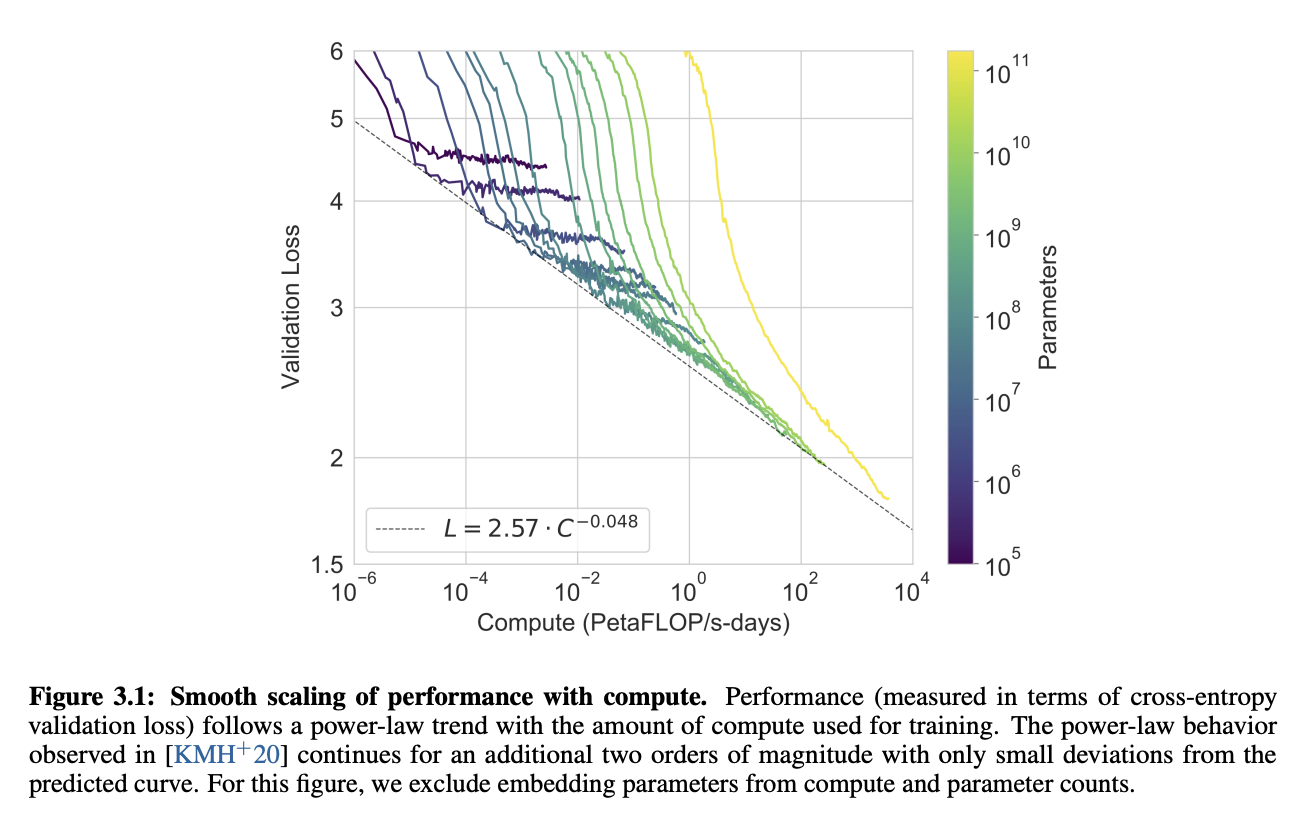

交叉熵损失和训练中的计算浮点数服从幂律分布,

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!