【余弦相似性】ON THE BYZANTINE ROBUSTNESS OF CLUSTERED FEDERATED LEARNING

ON THE BYZANTINE ROBUSTNESS OF CLUSTERED FEDERATED LEARNING论聚类联邦学习的拜占庭鲁棒性

- Abstract

- 1.INTRODUCTION

- 2.CLUSTERED FEDERATED LEARNING

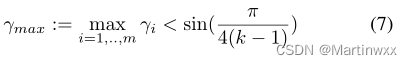

- **Theorem 1:Separation Theorem + Corollary**

- Algorithm:

- CFL for the Byzantine Setting:

- 3. RELATED WORK

- 4. EXPERIMENTS

- 5. CONCLUSION

Abstract

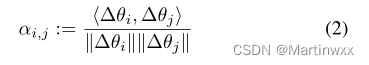

本文提出:根据参数更新之间的 成对余弦相似度 将客户端群体分为不同的组

1.INTRODUCTION

-

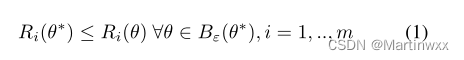

假设1:

*所有客户端的数据同时产生分布的风险:

R i ( θ ) = ∫ l ( f θ ( x ) , y ) d φ i ( x , y ) R_i(\theta)=\int{l(f_\theta(x),y)d\varphi_i(x,y)} Ri(θ)=∫l(fθ(x),y)dφi(x,y)

与分布 φ i \varphi_i φi相关的风险函数, l l l是一个合适的损失函数。

两个客户端的分布为 φ i , φ j \varphi_i,\varphi_j φi,φj ,如果满足假设1 则同分布。 -

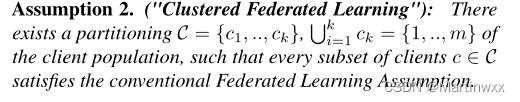

假设2:

CFL利用FL的损失曲面几何特性,识别聚类结构 c c c

CFL利用FL的损失曲面几何特性,识别聚类结构 c c c -

拜占庭攻击:

声明一个特定的客户端集群, 良性客户端 c b e n i g n ∈ C c_{benign}\in \mathcal{C} cbenign∈C ,对抗性: C = { c b e n i g n } ∪ C a d v \mathcal{C}=\lbrace c_{benign}\rbrace\cup\mathcal{C}_{adv} C={cbenign}∪Cadv

2.CLUSTERED FEDERATED LEARNING

FL可以通过仅检查余弦相似度来推断客户端及其数据的聚类结构 C \mathcal{C} C

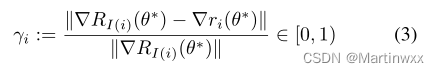

Theorem 1:Separation Theorem + Corollary

m m m 客户端

D 1 , . . . , D m D_1,...,D_m D1,...,Dm 客户端上的数据集

φ 1 , . . . , φ k \varphi_1,...,\varphi_k φ1,...,φk : k k k 个数据分布

D i ∽ φ I ( i ) ( x , y ) D_i \backsim \varphi_{I_(i)}(x,y) Di∽φI(i)(x,y)

r i ( θ ) r_i(\theta) ri(θ) 每个客户端的经验风险

θ ∗ \theta^\ast θ∗ 客户端经验风险的平稳解

在 θ ∗ \theta^\ast θ∗ 平稳解上进行双分区

满足(7) 则(4)中的聚类机制都是正确的聚类

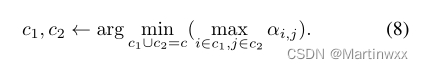

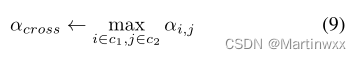

Algorithm:

在全局模型均值聚合前,服务器计算成对余弦相似度矩阵 α \alpha α 并计算集群候选

如果两个集群见得最大相似度低于 α c r o s s t h r e s h \alpha_{cross}^{thresh} αcrossthresh , 就将主集群划分为两个候选集群。对每个客户端分别执行模型聚合。

CFL for the Byzantine Setting:

因为实验中,设置大多数客户端都是良性的,可以通过将不属于最大集群的所有客户端排除在训练之外来节省工作量。

3. RELATED WORK

鲁棒聚集规则,这些规则依赖于梯度相似度、几何中值聚集、冗余通信或自适应模型质量估计。

[7] Peva Blanchard, Rachid Guerraoui, Julien Stainer, et al.,“Machine learning with adversaries: Byzantine tolerant gradient descent,” in Advances in Neural Information Processing Systems, 2017, pp. 119–129.

[8] El Mahdi El Mhamdi, Rachid Guerraoui, and Sébastien Rouault, “The hidden vulnerability of distributed learning in byzantium,” arXiv preprint arXiv:1802.07927,2018.

当前研究的不足:

本文贡献:

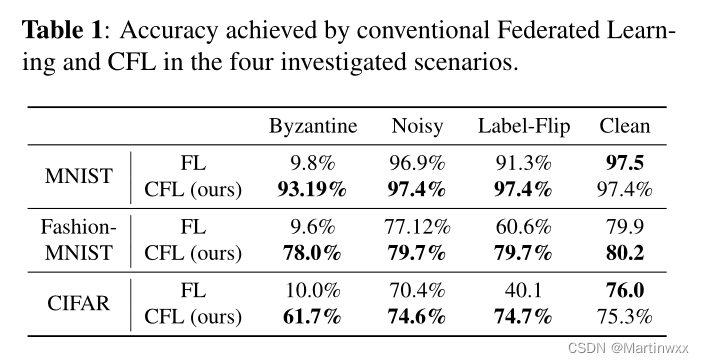

4. EXPERIMENTS

数据集: MNIST, Fashion-MNIST和CIFAR-10

模型: 批量大小为 100 的 SGD 训练卷积深度神经网络

客户端数量: 100

恶意客户端数: 30%

攻击方式:

高斯攻击: 标准差为 1(模拟对协同训练过程的无定向攻击);标签翻转攻击: 标签为0,将模型不成比例的偏向于一个特定类;噪声攻击: 向所有像素和通道添加独立均匀噪声 x ^ = x + U ( − 10 , 10 ) \hat{x} = x+ \mathcal{U}(-10,10) x^=x+U(−10,10) ,模拟Non-iid噪声失真;Clean无攻击。

余弦相似度阈值: α c r o s s t h r e s h = 0.02 \alpha_{cross}^{thresh}= 0.02 αcrossthresh=0.02

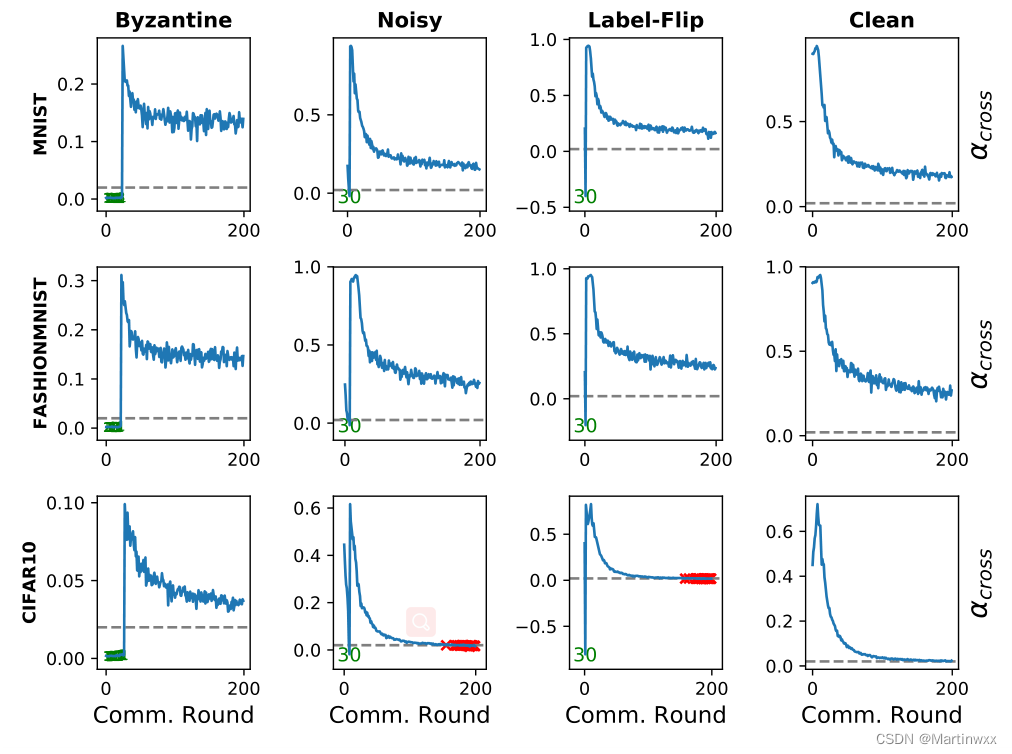

70个良性客户端和30个恶意客户端在前200轮通信中α交叉的发展情况:

绿色: 恶意客户端从良性集群中分离

红色: 良性客户端从主集群移除

在所有数据集和不同的对抗场景下,所有恶意客户端从训练中移除只需要不到40个通信回合。

噪声和标签翻转: 被一次性分离

高斯: 需要几轮

Clean: 完全不分离,不影响收敛。

在 CIFAR 数据集上,噪声和标签翻转 在 170 次通信后,交叉聚类相似性降到阈值以下,导致良性客户端从主集群中分离。

可解决方案: 随着训练降低 α \alpha α 阈值。

每次实验,恶意客户端都被首先完全分离,200轮通信后进度如图:

5. CONCLUSION

好。

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!