python 爬取樊登读书官网试听课视频链接

最近在学习上手python,开发群里有个需求是老板看上了樊登读书的视频,想爬取一下视频组织培训用,我看到后正好可以练练手就尝试写了个脚本,代码很简单,一个方法。

思路

1,分析网址,发现每一本书链接都是http://dushu.fandengds.com/news/+数字.html

比如:http://dushu.fandengds.com/news/643.html

然后查看源代码发现视频html标签都是

综上可知,代码思路很清晰了,就是简单的循环数字请求每一本书的连接我代码是0-900,可以自行定义多少,然后通过解析html视频标签source 得到视频连接最后把链接写到表格保存到本地

爬取用到的python库:

requests 请求网络库

xlwt 读写excel 库

BeautifulSoup 解析html库

库的安装和使用详解可自行百度

##上代码

import randomimport requests

import xlwt

from bs4 import BeautifulSoupdef fandeng(index):headers = {'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9','Accept-Encoding': 'gzip, deflate','Accept-Language': 'zh-CN,zh;q=0.9','Connection': 'keep-alive','User-Agent': 'Mozilla/5.0 (Windows3 NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'}timeout = random.choice(range(80, 180))#生产请求延时随机数,模拟网页请求rs = requests.get("http://dushu.fandengds.com/news/" + index + ".html", headers=headers, timeout=timeout)rs.encoding = 'utf-8'return rs.textif __name__ == '__main__':wbk = xlwt.Workbook() #exclel 对象sheet = wbk.add_sheet('第一页')a = 0for value in range(0, 900):# print(value)html = fandeng(str(value))soup = BeautifulSoup(html, 'html.parser')title = soup.title.stringtitleList = soup.find_all('source')#得到的是 for link in titleList:#循环可以不要因为确定只有一个视频链接a = a + 1url = link.get('src')#得到的是视频连接 http://v.fandeng123.com/video/trial/fb6d1c1260740d3961f1df00a7b8d6bf_6d265e.mp4" type="video/mp4sheet.write(a, 1, url) # 几行1列是视频连接sheet.write(a, 0, title) # 几行0是书名print(str(a))wbk.save('樊登读书.xls')#保存成excle

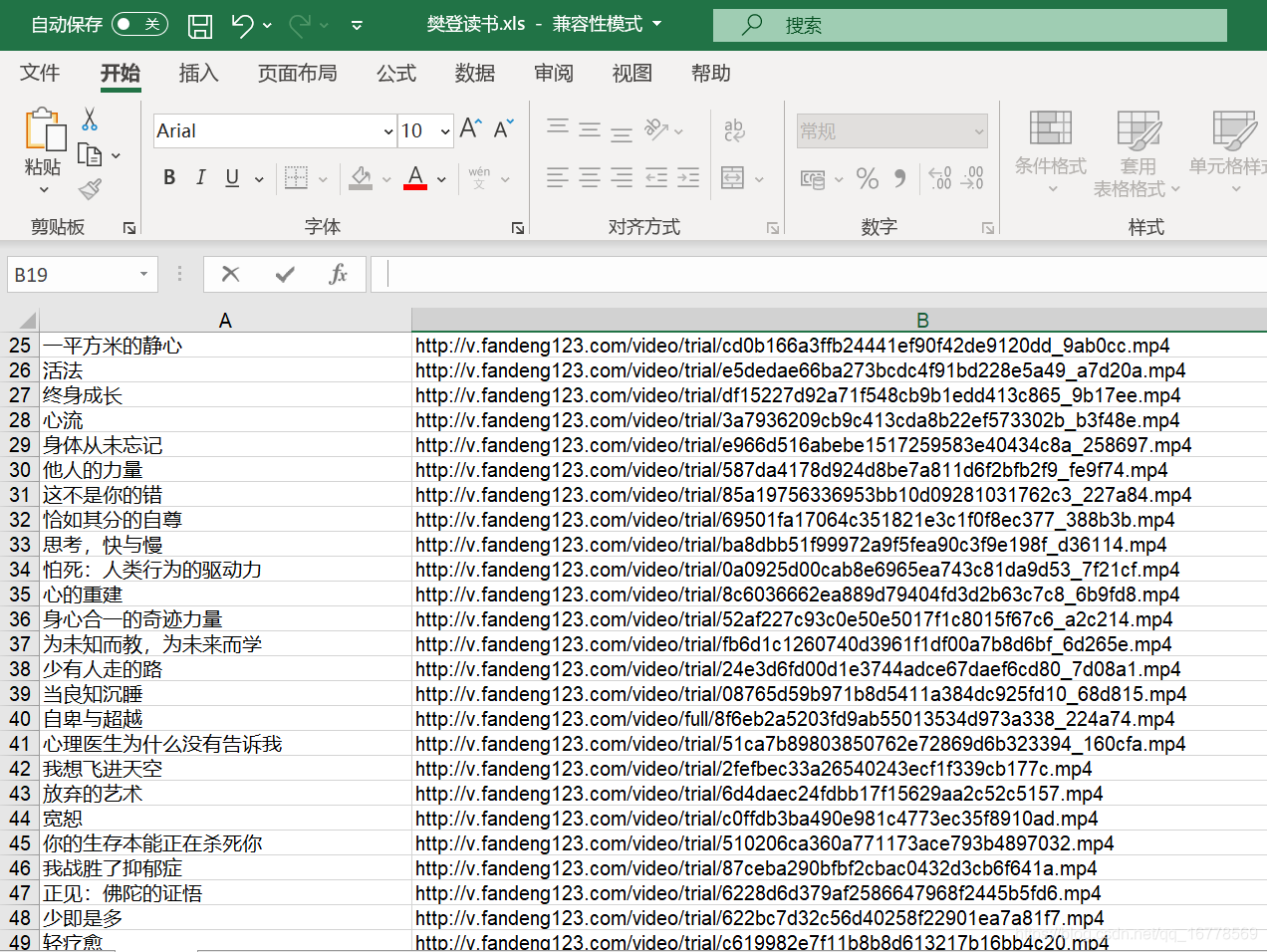

#效果截图

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!