应急响应 一

应急响应 一

- 应急响应基础

- 演示:windows+IIS+SQL日志搜索

- linux+BT+Nginx+tp5日志分析 后门

- Linux+Javaweb+st2-日志,后门

应急响应基础

服务器受到攻击后的一些表现

网站表现:网页被篡改 --> 网页丢失 --> 乱码等

文件表现:文件被篡改 - -> 丢失 --> 泄漏

系统表现:系统卡顿 --> CPU爆满 --> 服务器宕机

流量表现:大量(异常)数据包 --> 外部链接 --> 网络卡顿

第三方服务表现:服务异常 --> 运行异常

应急响应过程:

应急响应目的:分析攻击时间、攻击操作、攻击结果、安全修复等并给出合理的解决方案。

第一阶段保护:断网,保护现场,看是否能够恢复数据 。

第二阶段分析:对入侵过程进行分析,常见方法为指纹库搜索、日志分析、后门追查分析、漏洞检查分析等 。

第三阶段复现:还原攻击过程,模拟攻击者入侵思路,关注攻击者在系统中应用的漏洞、手法 。

第四阶段修复:分析原因后,修补相关系统、应用漏洞,如果存在后门或弱口令,及时清除并整改。

第五阶段建议:对攻击者利用的漏洞进行修补,加强系统安全同时提高安全意识。

应急响应需要具备的知识点:

1、熟悉常用的web攻击技术。

2、熟悉系统中间件等相关日志启用,日志存放位置查看日志的方式等。

3、熟悉日志中记录数据分类和分析等。

前期准备工作:

1、收集目标服务器信息

2、部署相关分析软件和平台等

3、整理相关安全渗透测试工具指纹库

4、针对异常表现第一时间触发思路从受害方提供的信息预估入侵面以及权限面进行排查,分为有明确信息和无明确信息两种情况:

1、如果有明确信息的情况下,基本提出关于时间、操作以及指纹这一类的相关信息基于时间:如果受害方提供了文件被修改日期、异常登录日期,那么我们就可以锁定这一时期的相关日志进行查看,不必去大海捞针一天天地看日志了。从而有针对性地对目标攻击事件进行分析。基于操作:如果受害方提供了被删除、被加密的数据、文件位置,如数据库、磁盘等,那么我们可以根据攻击者的操作判断它入侵了哪些地方并可能分析出攻击过程。基于指纹:如果受害方只说是网页被修改、网站被上马,那么我们可以根据攻击工具的指纹、木马的指纹、病毒的指纹、修改的内容等判断攻击者使用了何种工具、处于何种技术水平。

2、如果无明确信息的情况下,那么就需要排查全部可能入侵的手法:web漏洞:检查源码类别和漏洞情况中间件漏洞:检查对应版本和漏洞情况第三方应用漏洞:检查是否存在漏洞应用操作系统漏洞:检查是否存在系统漏洞其他安全问题:检查相关用户口令以及后门扫描

演示:windows+IIS+SQL日志搜索

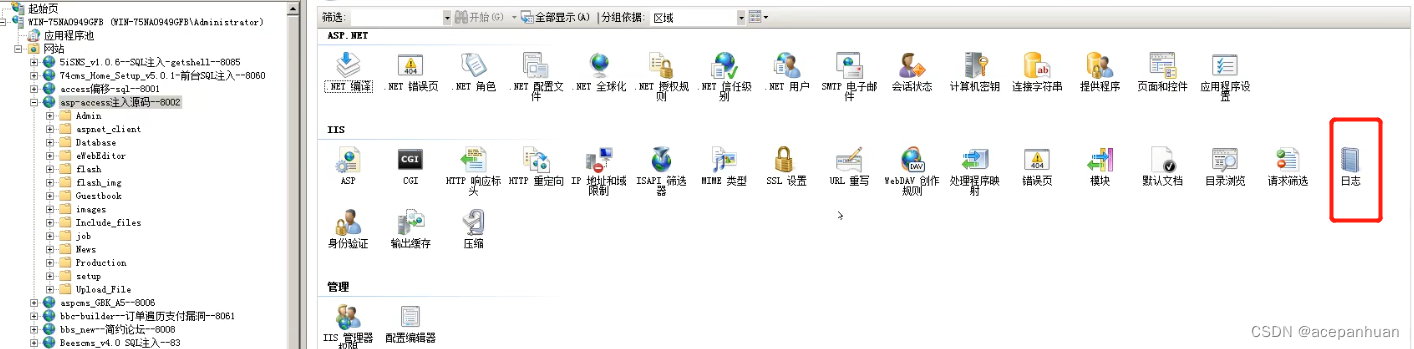

1.打开IIS找到日志存放位置:

网站运行日志一般都是开启的除非管理员手动关闭,web服务主要记录web请求类的数据,数据库日志记录数据库操作指令的一些记录,系统日志记录操作系统指令的一些记录,一般都是默认开启,根据不同日志可以找到历史操作信息,来判断攻击攻击者做了那些操作,但攻击者删掉所有日志文件那就难了。

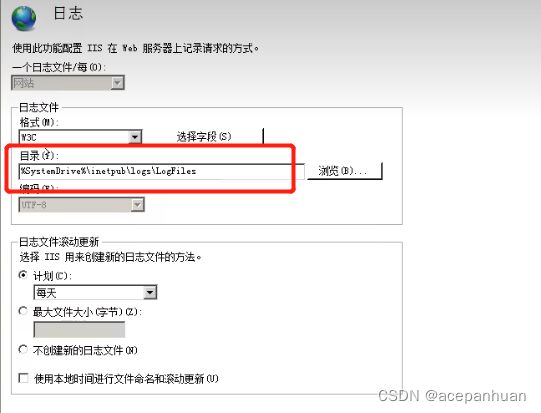

2.根据网站的ID号寻找对应的日志

一个web服务可能运行多个网站,通过网站ID号找到被攻击网站的日志。

日志默认是一天存储一个文件,根据被攻击日期提取出前后近几天的日志进行分析

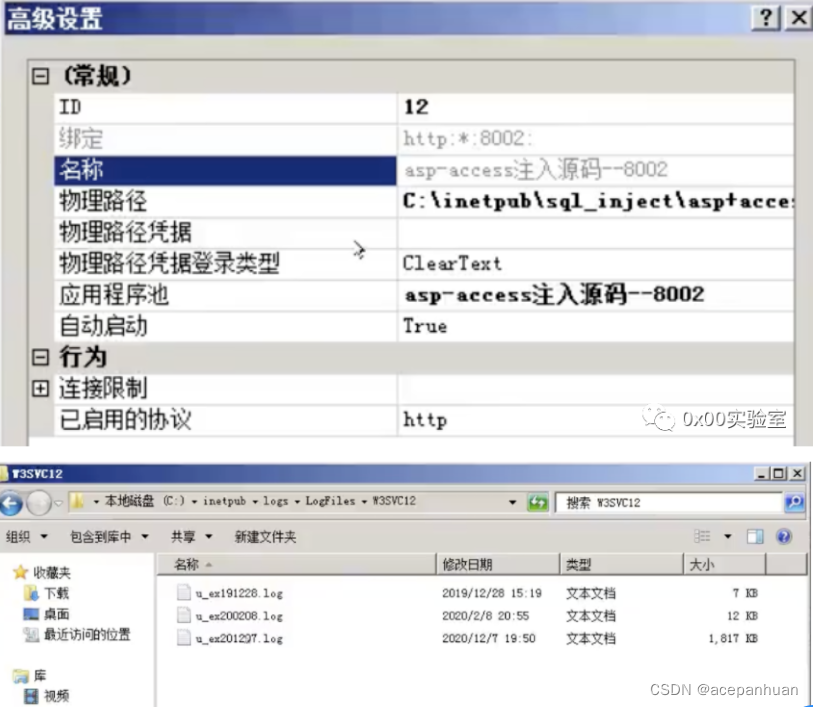

3.分析日志,找攻击的数据请求。

日志中包含请求时间,请求者的IP,请求方法,请求的资源,请求UA等信息

这里通过关键字查询发现url中出现了select,那么可以判断是注入攻击,使用的是SQLMAP进行的攻击的。

也可以通过工具的指纹查询:(sqlmap/冰蝎/蚁剑/awvs/xray等的浏览器头部,当然也可能是百度、谷歌的爬虫)

实际情况下要综合考虑网站的功能,看是否存在文件上传,sql注入,RCE等多种漏洞来进行关键字搜索。

linux+BT+Nginx+tp5日志分析 后门

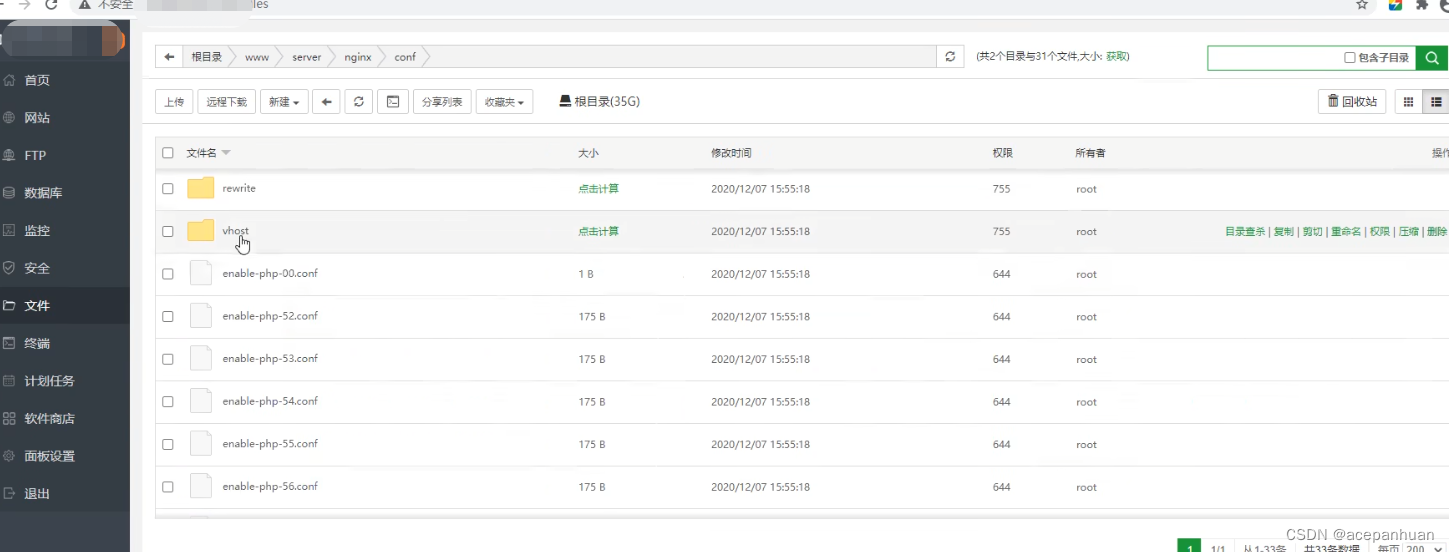

1.登录宝塔面板下载日志到本地

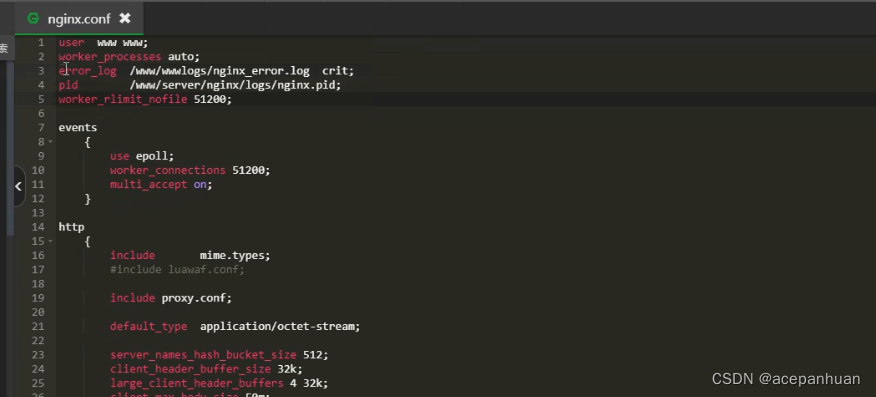

Nginx 做Web服务的话,他的日志文件地址,在conf配置文件中查找。首先找到Nginx目录,然后进入conf,打开nginx.conf。 .log 后准名的就是日志

找到日志存放位置,然后下载日志到本机进行分析。

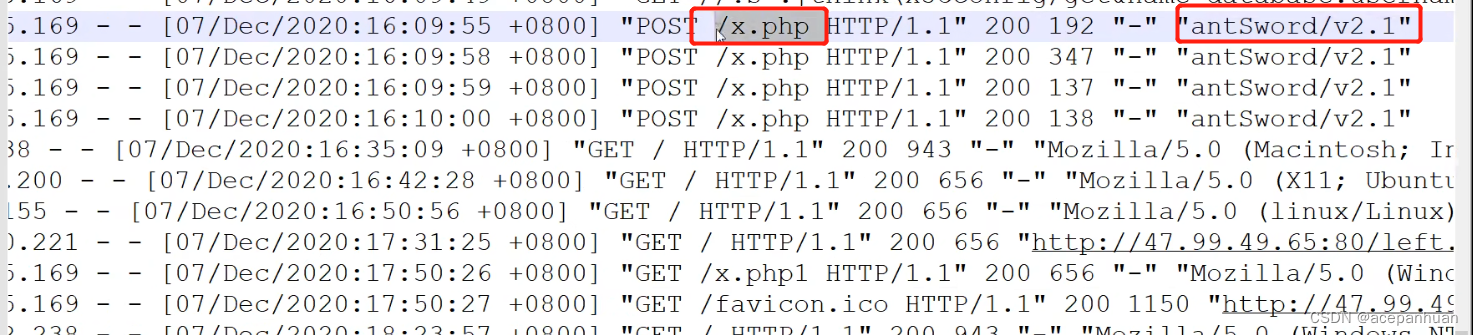

2.分析日志

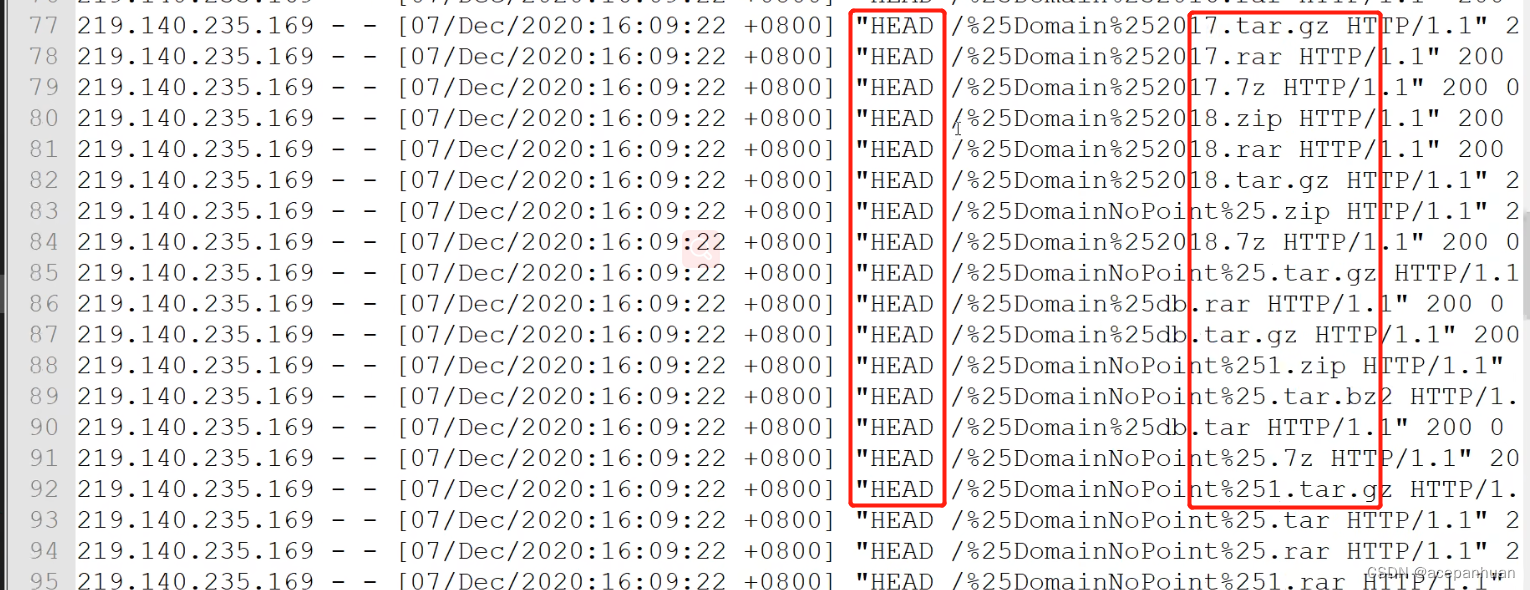

HEAD请求,一般扫描目录常用的请求方式。

演示1和2只是作为一个演示,在实际应用中,日志文件是相当庞大的,打开文件人工去检索的话效率太低太低,一般都会使用工具来帮我进行检索。

日志分析工具介绍:https://www.cnblogs.com/xiaozi/p/13198071.html

实际中用的最多的是 ELK 和 Splunk,这两款工具。

Linux+Javaweb+st2-日志,后门

故事回顾:群友接到客户的反馈要求简要分析攻击方式,找出漏洞,修复并溯源 ,

提供了被攻击时间,以及后门文件,后门文件是caiyun.jsp

在tomcat中:localhost_access_log对应的网站的请求日志

分析流程:

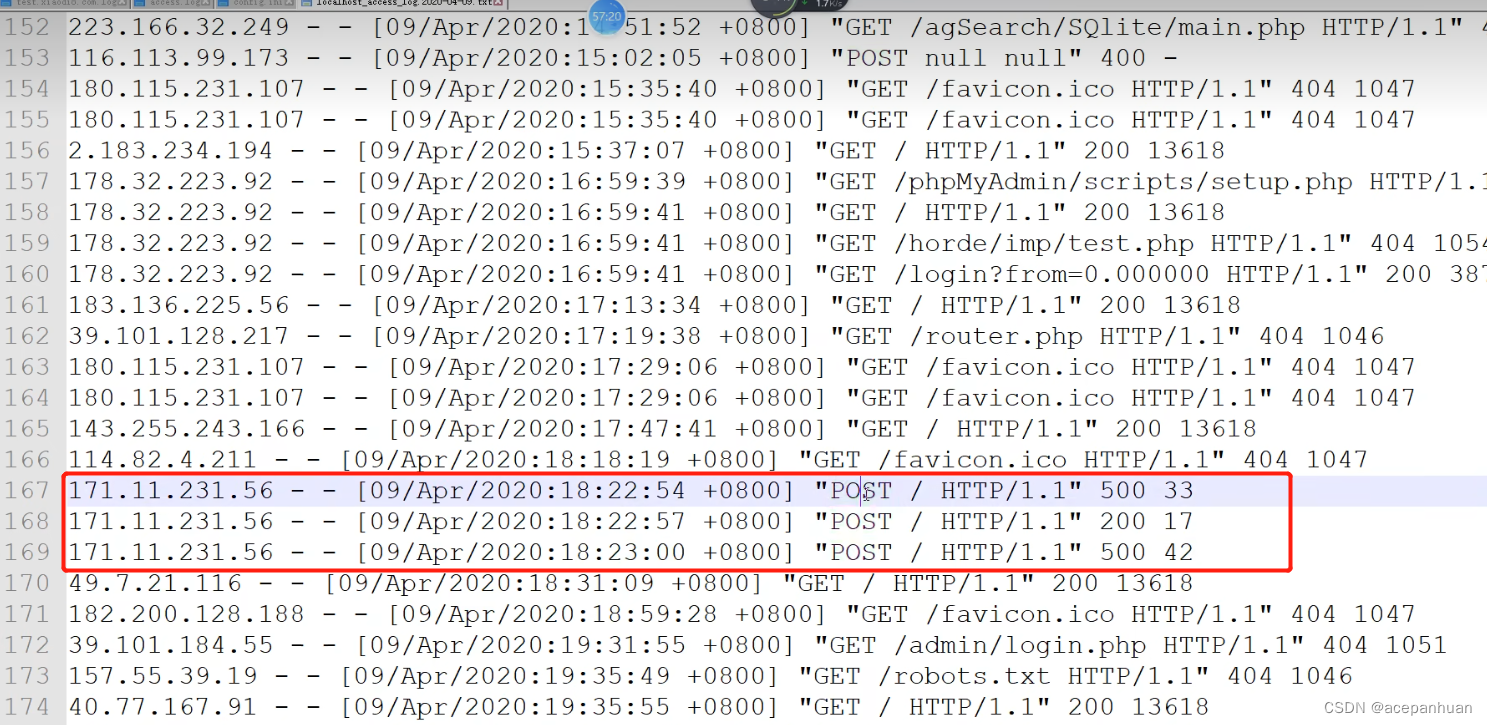

通过给定的被攻击时间,找到该时间段的日志,进行分析,攻击是20年4月9日下午18点22分左右,

打开20年4月9日日志。

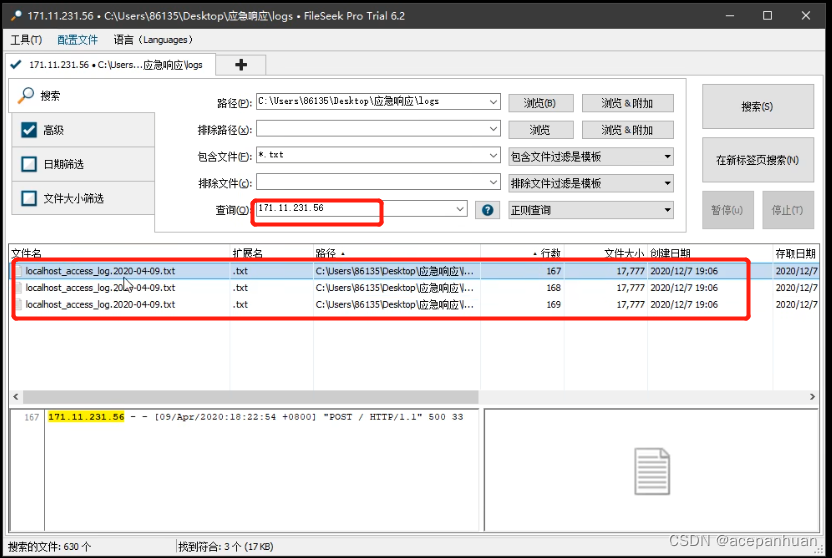

发现这段时间前后都是大部分是GET请求,这个时间段正好是被攻击的时间出现了POST请求,这里可能是连接WEBSHELL,定位这个IP。看这个IP的前后的都做了那些操作。前后这么多天日志,挨个查找去看很麻烦,这个时候可以使用ELK或其他工具,这里使用一款小工具来对日志进行分析FileSeek文件搜索工具。

下图查询ip,看那些时间段的日志出现看这个IP

发现这个IP只有在1月9日中出现过,也就是刚才发现他的日志文件中出现过,这个感觉这个IP线索断了。

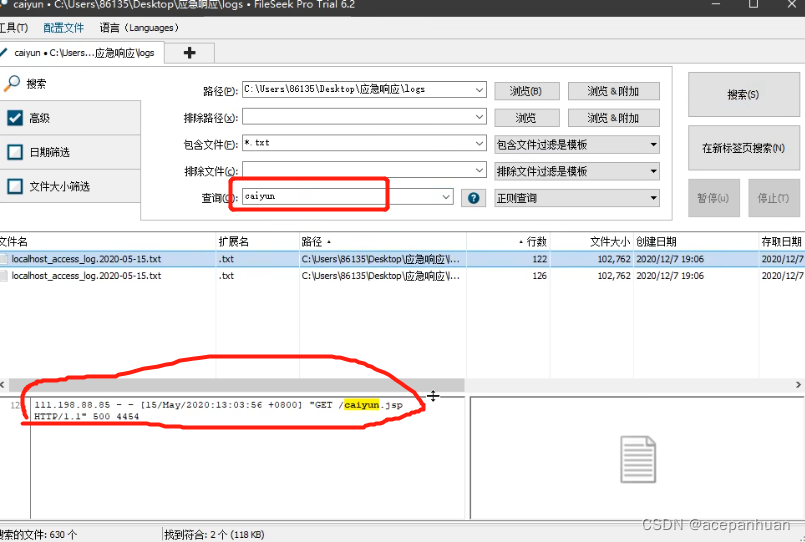

查看后门文件:caiyun.jsp

1.以caiyun.jsp为坐标,查看谁访问了后门文件,扩大黑客的ip地址重复之前的漏洞

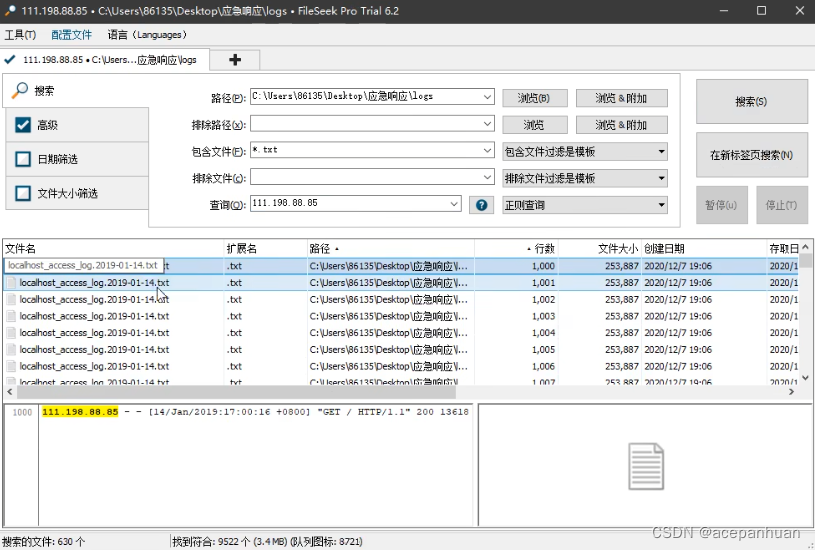

以这个ip在作为查询条件看这个IP做了那些操作:

既然上传了WEBSHELL那么在请求数据日志中应该能查询到写入后门的请求,根据后门内容关键字进行搜索,可以找到写入后门文件的数据包请求,根据这个请求可以反推网站存在的漏洞。

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!