最近(2025 年 2 月)DeepSeek团队在推特上发布了一篇新的论文,这个论文解决的是模型在处理长上下文窗口的能力。曾经谷歌发布过一个论文叫做 《Attention is all you need 》这个Attention 叫做注意力机制,在大模型的处理中,是一个非常关键的技术,就像你读一本书,你需要全都读下来,每个字都要看一遍,之前的注意力机制叫做 full attention 就是你需要关注到每个字和每个字之间的相互关系。但是这次deepseek 的NSA 原生稀疏注意力机制,它会想一些办法去略读,它不需要关注这篇文章所有词之间的相关关系,而是只要把其中重要的一些,把它看到就好了。

下面让我们仔细来看看这篇论文

一、论文的核心观点

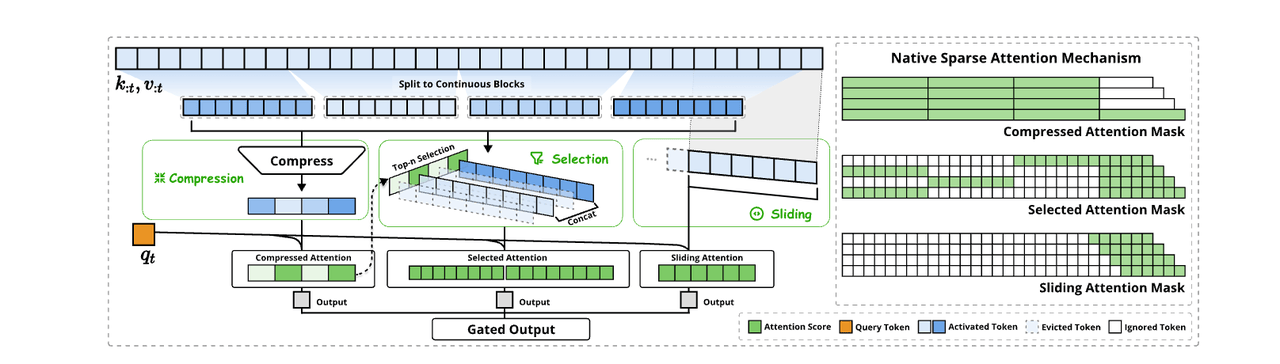

论文提出了一种原生稀疏注意力机制(NSA),它将算法创新与硬件对齐优化相结合,以实现高效的长上下文模型。

1、NSA 采用动态分层稀疏策略,结合粗粒度标记压缩和细粒度标记选择,以保持全局上下文意识和局部精度。这样既有对全局的理解也能减少冗余的计算。

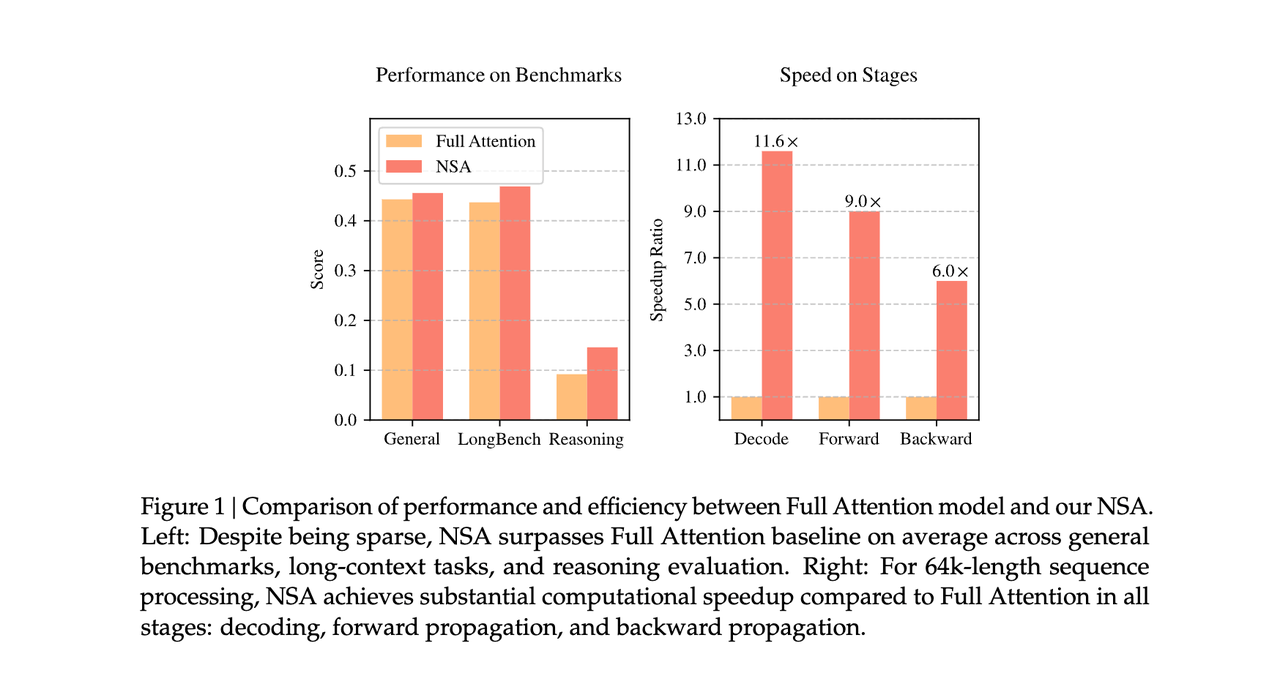

2、对 GPU 的 Tensor Core 特性设计高效的计算内核,让NSA 在 64k 长度序列的解码、正向传播和反向传播方面相对于全注意力( full attention)实现了显著的加速,验证了其在整个模型生命周期中的效率。

3、实现了端到端训练,在不牺牲模型性能的情况下减少了预训练的计算。实验表明,使用 NSA 预训练的模型在通用理解、长上下文任务和基于指令的推理方面保持了或超过了全注意力( full attention)模型。同时,大幅降低算力成本。

二、研究方法

NSA 的核心在于其动态层次化的稀疏策略,具体包括以下几个方面:

1、令牌压缩(Token Compression):通过将连续的键(key)或值(value)序列聚合为块级表示,减少计算负担。压缩后的键和值能够捕获整个块的信息,从而实现粗粒度的语义信息捕获。(简单来说就是:它把所有的token都切成块,每块提炼出一些关键信息,相当于做了一个摘要)

2、令牌选择(Token Selection):在压缩的基础上,选择性地保留一些关键的键和值,以保留重要的细粒度信息。这一过程通过块级选择策略实现,即对键和值序列进行空间连续的块划分,并根据块的重要性分数选择最重要的块。(简单来说就是:选择这些块里面,这些关键信息里,一些重要的词的意思。就像这些块里面的内容,我并不是都需要,所以我会选择一些关键词,或者是跳过一些不太重要的词)

3、滑动窗口(Sliding Window):为了处理局部上下文信息,NSA 引入了滑动窗口机制,专门处理局部模式,使模型能够更有效地学习全局和局部特征。(简单来说就是:刚才切的这些块之间可能还会有一些关联)

大概就是通过这样一个算法,让大模型产生一个稀疏注意力,这样的话,它不需要关注全局所有词之间的相关关系,而是只要把其中重要的一些找到就好了。

deepseek团队用这样的方法去做了测评,甚至评测出的结果甚至比全注意力( full attention)还要好,而且它的计算的能耗压缩是非常显著的,在这个全流程的过程当中,节省的成本不只是一点半点

同时他们不但在算法上有优化,还在硬件上也有优化,硬件也能让效能有所提升。当然硬件也不是说在英伟达的卡上面做优化。

三、实验

1、实验设置

- 预训练:使用 27B 参数的 Transformer 模型,预训练 260B 个 token。

- 长文本适应:在 32k 长度文本上进行持续训练和监督微调 (SFT),以实现长文本适应。

- 基线模型:Full Attention 模型,以及其他稀疏注意力方法,例如 H2O、infLLM、Quest 和 Exact-Top。

2、评估指标

- 通用语言评估 (例如,MMLU)

- 长文本评估 (例如,LongBench)

- Chain-of-thought 推理评估 (例如,AIME)

3、实验结果

- NSA 在预训练过程中表现出稳定的收敛性,并且在损失值上优于全注意力模型。

- 通用评估:在多个基准测试中,NSA 在知识、推理和编码任务上均表现出色,甚至在某些指标上超过了全注意力模型。例如,在 DROP 和 GSM8K 测试中,NSA 分别提高了 0.042 和 0.034 的准确率。

- 长文本评估:NSA 在 64k 上下文的 Needle-in-a-Haystack 测试中,NSA 实现了完美的检索准确率。在 LongBench 测试中,NSA 的平均得分超过了所有基线方法,包括全注意力模型。

- 推理评估:在 AIME 基准测试中,NSA 在 8k 和 16k 序列长度上均优于全注意力模型,显示出其在复杂推理任务中的优势。

- 效率分析:NSA 在训练和解码速度上均优于全注意力模型:训练速度:在 64k 序列长度下,NSA 实现了高达 9.0× 的前向速度提升和 6.0× 的反向速度提升。解码速度:由于减少了 KV 缓存的加载量,NSA 在解码过程中实现了高达 11.6× 的速度提升。

四、关键结论

NSA 通过其层次化的稀疏注意力设计,在保持全注意力模型性能的同时,实现了显著的计算效率提升。具体来说:

- 性能:NSA 在多个基准测试中表现出色,尤其是在需要长序列理解和复杂推理的任务中。

- 效率:NSA 在训练和推理过程中均实现了显著的速度提升,特别是在处理长序列时,其优势更加明显。

- 可训练性:NSA 支持端到端的训练,减少了预训练计算成本,同时保持了模型性能。

五、Grok3 是什么

Grok3是由埃隆·马斯克旗下的xAI公司开发的第三代大语言模型,于2025年2月17日正式发布。Grok3 目前有最大的算力集群,它是用20万块H100来训练出来的大模型,它的进展速度是非常快的,在非常的时间内,就提升到了鼻尖 OpenAI 01 03等等这些模型的水平,甚至在这个数学,编程能力方面是有超越的。

但是 Grok3 在算力的消耗方面、成本方面都是是非常巨大的,是deepseek v1的 263倍。所以巨大的算力是Grok3的一个典型的特征,在发布会中,也提到了多模态的能力,也结合了应用作了一些优化,目前Grok3最大的这个模型还在训练中。接下来还会有更多的测评出来。

以下是其主要特点和功能:

1、训练与硬件

- 超强算力:Grok3的训练得益于xAI公司的Colossus超级计算机,该系统配备了10万个NVIDIA H100 GPU,提供了超过2亿个GPU小时的计算资源,计算能力是上一代Grok2的十倍。

- 合成数据训练:Grok3在合成数据的基础上进行训练,能够通过重读数据来反思所犯的错误,从而达到逻辑上的一致性。

2、核心功能

- 思维链推理能力:Grok3引入了“思维链”(Chain of Thought)推理机制,模仿人类的认知过程,使其在面对复杂查询时能够以更连贯和有逻辑的方式反应。

- 多模态能力:Grok3具备强大的多模态能力,能够同时处理图像、视频和3D动画数据,展示了其强大的创作能力。

- DeepSearch模式:该模式能够搜索互联网和X平台(前Twitter)的内容,用AI进行深度研究,分析这些信息,并为用户提供精确的搜索结果和详细答案。

- Big Brain模式:此模式使用更高的计算资源和更深入的推理过程,旨在处理和解决更复杂的问题。

3、性能表现

- 多项任务领先性能:在数学推理、科学逻辑推理和代码编写等多个基准测试中,Grok3超过了竞争对手,如DeepSeek-v3、GPT-4o和Gemini-2 pro。

- 高分评测:在LMSYS大模型竞技场中,Grok3以1400分的高分遥遥领先,超越了GPT-4、Claude 3.5 Sonnet和Gemini 2.0 Pro等主流模型。

Grok3以其强大的推理能力、多模态处理能力和卓越的性能表现,展现了在人工智能领域的巨大潜力和创新。

六、DeepSeek VS Grok3

DeepSeek和Grok3在多个方面存在显著差异。

- DeepSeek采用MoE(Mixture of Experts)架构,计算效率高,适合数学、代码推理任务,而Grok3采用扩展的Transformer架构并结合指令优化,擅长社交数据分析和多轮问答。

- 在数学推理方面,Grok3在AIME 2025评测中取得最高分,表现优于DeepSeek。

- DeepSeek完全开源,支持企业私有化部署,适用于本地AI计算方案,而Grok3则深度集成了特斯拉生态,如Optimus机器人和FSD自动驾驶系统。

- 在应用场景上,DeepSeek更适合企业级服务和本土化应用,如微信AI搜索和政务系统流程优化,而Grok3则在科研与复杂推理、创意编程和深度信息检索方面表现出色。

此外,DeepSeek在中文语义理解准确率上超过Grok3,而Grok3则在多模态处理方面更具优势,支持图像、视频和3D建模分析。

两个对比过后,Grok3靠大算力产生更好的智能,而deepseek 仍然在开源这条路上探索,所以究竟哪个更好,我想每个人心中都会有自己的答案吧。

作者:贝琳_belin分享各种AI知识和干货