【迁移攻击笔记】2019.11分批次集成攻击A New Ensemble Adversarial Attack Powered by Long-term Gradient Memories

0.总览

上交和阿里巴巴团队的一篇我觉得是把集成迁移攻击研究透了的文章。每个trcik都有很复杂的数学支撑,

1.Introduction

①目前主流的迁移方法:ensemble-based 和 GAN, 对算力和内存要求高。

②因此提出SMBEA(Serial Mini-Batch Ensemble Attack),基于俩个先验:模型迁移相当于网络泛化;边界相似度比扰动大小的限制更重要。

③将集成模型库分成很多批次来训练,训练下一个批次时继承上一个批次的信息且保证之前批次都可以攻击成功。

2.SMEBA

①批次内模型集成策略

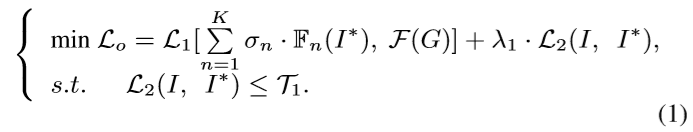

首先,之前的Loss一般是对结果计算:

本文方法新加入:加入feature maps的loss部分:(此处我不太理解,不知道是不是类似ILA)

然后是三种不同的批次内ensemble策略:

然后是三种不同的批次内ensemble策略:

②批次内更新策略:

5个备选:SGD,MSGD,Adagrad,RMS,Adam。下图是Adam更新策略的流程图,Adam用g防止局部最优和过拟合以提高迁移率,用g方来控制不同像素点自适应的学习率以找到合适每个像素点自身的搜索步长。

③批次间继承策略:

通过上一层的结果来初始化:

3.实验结果

希望看到这里的朋友可以关注一下我~~我会定期更新一些文章和自己的理解,希望可以对你有用~

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场,不承担相关法律责任。如若转载,请注明出处。 如若内容造成侵权/违法违规/事实不符,请点击【内容举报】进行投诉反馈!